Getreu dem Motto: “you answered – we listened” hat unser NWS-Platform-Team diese Woche für unsere Kunden neue Optionen zum Erstellen von Managed Kubernetes Clustern eingeführt, die im folgenden kurz erläutert und vorgestellt werden:

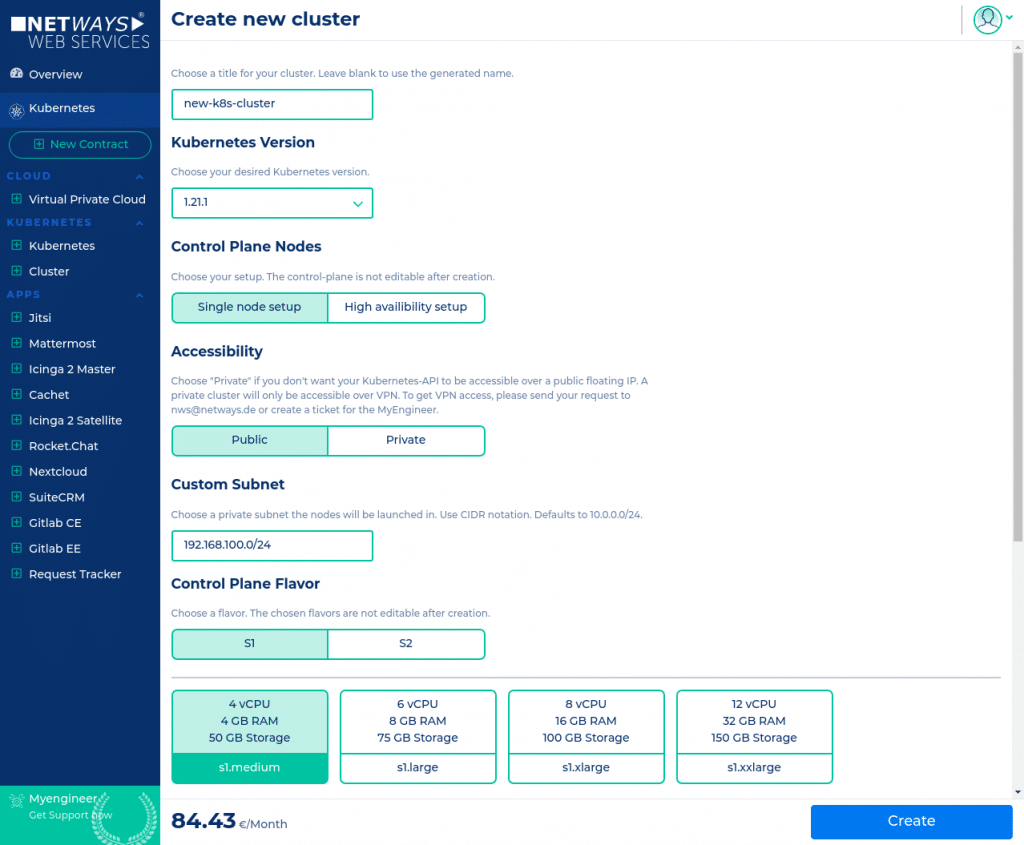

1. Neue Kubernetes Versionen

Das neueste Kubernetes Major Release 1.21 ist jetzt – einen Monat nach dem offiziellem Release – auch für NWS Kunden einsatzbereit! Änderungen und Neuigkeiten findet man wie gewohnt im offiziellen Changelog.

Neben der aktuellen Version 1.21 gibt es weiterhin die Möglichkeit, Kubernetes Cluster in den Versionen 1.18, 1.19 und 1.20 zu erstellen. Die Version 1.18 ist jedoch bereits “End of Life” und deswegen nicht mehr unbedingt zu empfehlen.

2. Private Cluster

Beim Erstellen eines Clusters kann man ab sofort zwischen einem “Private” oder einem “Public” Cluster wählen. Damit wird die Erreichbarkeit der Kubernetes-API des Clusters gesteuert. Ein privater Cluster hat nur eine interne IP und keine weitere öffentliche Floating-IP und ist dementsprechend nur von innerhalb der Kundenumgebung (OpenStack- oder Kubernetes-Projekt) erreichbar oder via VPN.

3. Individuelle Subnetze

Ebenso kann beim Erstellen eines neuen Clusters das Subnetz – in dem die Nodes kommunizieren – frei gewählt werden. Das ist insbesondere dann hilfreich, wenn man einen privaten Kubernetes Cluster per VPN mit einem bestehenden Firmennetz verbindet!

4. Rotate CA

Das Rotieren der Kubernetes CA kann jetzt über die Web-Oberfläche angestoßen werden. Es wird eine neue Cluster CA erzeugt und entsprechend neue Schlüssel und Zertifikate für Service-Accounts und Kubernetes-Nodes verteilt. Die bestehende kubeconfig-Datei des Administrators muss dann durch eine neue ausgetauscht werden.

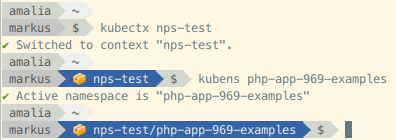

Kubernetes Tutorials

Wer sich nochmal eine genaue Anleitung, wie man schnell und einfach sein Managed Kubernetes bei NWS aufsetzt, durchlesen möchte, der findet diese und viele weitere Kubernetes Tutorials auf unserer Website. Gerne mal vorbeischauen!

Früher gab es keine Möglichkeit auf einem physischen Server Ressourcengrenzen für eine Anwendung zu setzen. Beanspruchte eine App viele Ressourcen, blieb für die anderen entsprechend wenig zur Verfügung. Dieses Problem wurde durch die Virtualisierung gelöst. Nun konnte die CPU von einem physikalischen Server auf mehrere Virtuelle Maschinen aufgeteilt werden. Jede VM bekommt hierbei feste Ressourcengrenzen zugeteilt und somit können mehrere Apps nebeneinander auf einem Server laufen, ohne sich gegenseitig die notwendigen Ressourcen streitig zu machen. Durch die Virtualisierung war nun auch die Möglichkeit der Skalierbarkeit gegeben. Bei Bedarf lassen sich die Ressourcen einer VM leicht erhöhen und später genauso wieder herunterdrehen. So lässt sich ein physischer Server wesentlich kosteneffizienter betreiben.

Früher gab es keine Möglichkeit auf einem physischen Server Ressourcengrenzen für eine Anwendung zu setzen. Beanspruchte eine App viele Ressourcen, blieb für die anderen entsprechend wenig zur Verfügung. Dieses Problem wurde durch die Virtualisierung gelöst. Nun konnte die CPU von einem physikalischen Server auf mehrere Virtuelle Maschinen aufgeteilt werden. Jede VM bekommt hierbei feste Ressourcengrenzen zugeteilt und somit können mehrere Apps nebeneinander auf einem Server laufen, ohne sich gegenseitig die notwendigen Ressourcen streitig zu machen. Durch die Virtualisierung war nun auch die Möglichkeit der Skalierbarkeit gegeben. Bei Bedarf lassen sich die Ressourcen einer VM leicht erhöhen und später genauso wieder herunterdrehen. So lässt sich ein physischer Server wesentlich kosteneffizienter betreiben. An dieser Stelle kommt nun Kubernetes ins Spiel. Denn irgendjemand muss bei den ganzen Microservices ja den Überblick und das Steuer in der Hand behalten. Das Kubernetes Projekt wurde 2014 von Google als OpenSource-Projekt veröffentlicht. Der Name kommt aus dem Griechischen und bedeutet so viel wie Steuermann/ Pilot. In Kurzform wird es auch oft als „k8s“ bezeichnet.

An dieser Stelle kommt nun Kubernetes ins Spiel. Denn irgendjemand muss bei den ganzen Microservices ja den Überblick und das Steuer in der Hand behalten. Das Kubernetes Projekt wurde 2014 von Google als OpenSource-Projekt veröffentlicht. Der Name kommt aus dem Griechischen und bedeutet so viel wie Steuermann/ Pilot. In Kurzform wird es auch oft als „k8s“ bezeichnet. Die größte Herausforderung bei Kubernetes liegt in der Komplexität des eigentlichen Erstellens, Betriebs und Instandhaltens des Kubernetes Clusters. Und hier kommt die gute Nachricht für Dich: diese Aufgaben liegen komplett bei uns. Wir sorgen im Hintergrund permanent für Updates, Backups und eine stabile zugrunde liegende Infrastruktur. Diese besteht auch hier aus unserer OpenStack Umgebung, mittels derer alle notwendigen VMs, Loadbalancer etc. gestartet werden. Unsere Kunden können also sämtliche Annehmlichkeiten von Kubernetes nutzen, ohne sich um den Aufbau des nötigen Fachwissens zum Betrieb eines K8s-Clusters kümmern zu müssen.

Die größte Herausforderung bei Kubernetes liegt in der Komplexität des eigentlichen Erstellens, Betriebs und Instandhaltens des Kubernetes Clusters. Und hier kommt die gute Nachricht für Dich: diese Aufgaben liegen komplett bei uns. Wir sorgen im Hintergrund permanent für Updates, Backups und eine stabile zugrunde liegende Infrastruktur. Diese besteht auch hier aus unserer OpenStack Umgebung, mittels derer alle notwendigen VMs, Loadbalancer etc. gestartet werden. Unsere Kunden können also sämtliche Annehmlichkeiten von Kubernetes nutzen, ohne sich um den Aufbau des nötigen Fachwissens zum Betrieb eines K8s-Clusters kümmern zu müssen.