Moderne IT entwickelt sich in unglaublichem Tempo weiter. Produkte und Software, die vor drei Jahren noch Standard waren, sind heute vielleicht schon Schnee von gestern. Um hier nicht den Überblick zu verlieren und immer auf dem neuesten Stand zu sein, bietet NETWAYS wie viele andere Open Source Dienstleister auch Trainings und Workshops an. Doch was genau unterscheidet diese beiden Modelle eigentlich voneinander? Und welche davon ist vielleicht die Richtige für dich?

Als Senior Manager Services ist Markus Waldmüller zusammen mit seinem Team unter anderem für die Einplanung unserer Open Source Spezialist:innen als (Co-)Trainer:innen verantwortlich. Er gibt dir einen Einblick, was wir bei NETWAYS Professional Services unter Trainings und Workshops verstehen, welche Voraussetzungen du mitbringen solltest und wie wir mit individuellen Anfragen und Wünschen umgehen.

Was sind eigentlich Anwenderschulungen?

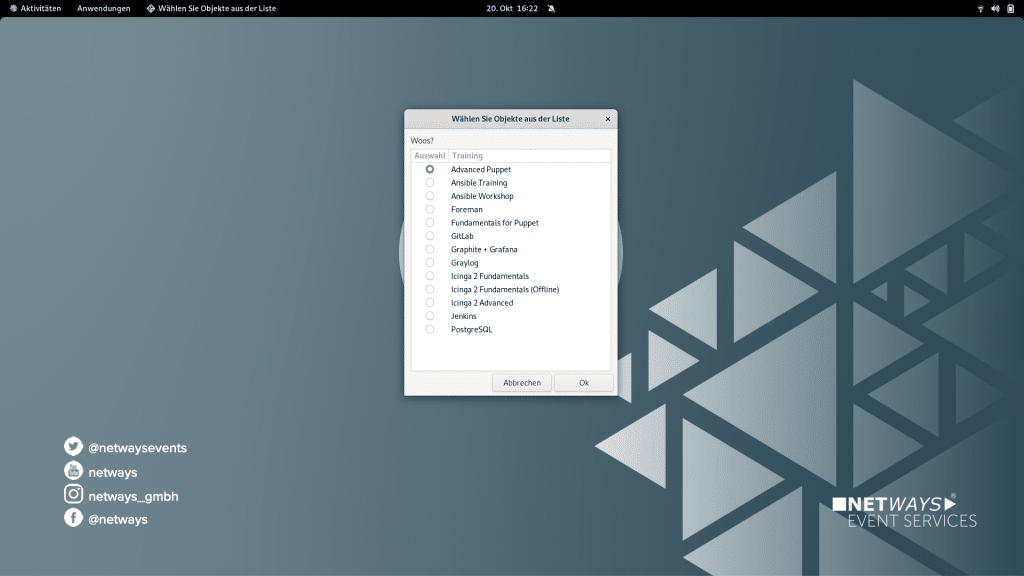

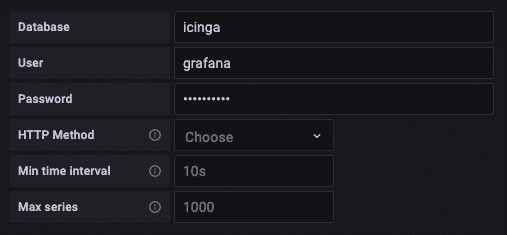

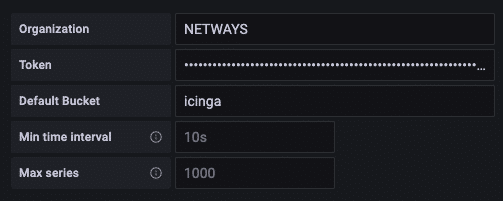

Anwenderschulungen bei NETWAYS bezeichnen wir intern in der Regel nur kurz als Schulungen bzw. Trainings. Wir bieten sie zu verschiedenen Open Source Anwendungen an, zum Beispiel Ansible, Icinga, Prometheus oder Kubernetes.

Schulungen bieten wir über unsere Webseite in regelmäßigen Abständen zur öffentlichen Teilnahme an. Das heißt, dass sich das Teilnehmerfeld sehr oft aus Menschen aus verschiedenen Firmen oder Organisationen mit unterschiedlichem Hintergrund zusammensetzt. Allerdings ist die Sprache hierbei auf Deutsch begrenzt. Außerdem gibt es seit der Pandemie bei uns eine gesunde Mischung aus Online-Trainings und Schulungen vor Ort.

Für diese Vor-Ort-Termine haben wir hier in Nürnberg ein eigenes NETWAYS Schulungszentrum, das sogenannte “Kesselhaus”. Dieses kann neben den Schulungen auch für andere Veranstaltungen gebucht werden. Spätestens hier findet vor, während und nach der Schulung – nicht zuletzt auch bei der gemeinsamen und reichlichen Nahrungsaufnahme – auch ein reger Austausch zwischen den Teilnehmer:innen statt. Du lernst also nicht nur den Umgang mit der von dir gewählten Anwendung, sondern kannst zeitgleich wertvolle Kontakte knüpfen. Die Möglichkeit, in besonderen Maß von einer Teilnahme zu profitieren, ist jederzeit vorhanden. Wenn deine Firma oder Organisation gleich mehrere Teilnehmer:innen zur Schulung schicken möchte, bieten wir hierfür entsprechende Staffelungen für Rabattcodes an.

Das besondere Merkmal einer NETWAYS Schulung ist, dass sie einen roten Faden hat und einem vorgegebenen Stoff folgt. So ist sichergestellt, dass alle Teilnehmer:innen der Schulung dieselben Grundinhalte und Best Practices vermittelt bekommen und darauf aufbauen können. Bei unseren Schulungen haben wir stets einen hohen Anteil an praktischen Übungen, sodass du dein neu erlangtes Wissen durch Übungen prüfen und vertiefen kannst. Wenn du einmal an einer Stelle nicht weiter kommst, bekommst Du Ad-hoc Hilfestellungen und Fragen können am spezifischen Problem beantwortet werden.

Findet die Schulung vor Ort statt, so erhalten die Teilnehmer:innen die Schulungsunterlagen (inkl. Aufgaben und Musterlösungen) auch noch mal in ausgedruckter Form. Bei Online-Terminen erfolgt dies zumindest in digitaler Form als PDF.

Interesse und Neugier, den Rest erledigen wir

Ein weiterer Aspekt ist, dass alle unsere Trainer:innen aus der Praxis stammen und den fest vorgegebenen Schulungsstoff sowie Pausen- und Abendgespräche auch mit großem Wissen ergänzen können. Damit diese Wissensvermittlung auch gewährleistet bleibt und unterschiedliche Vorkenntnisse bzw. Verhaltens- oder Arbeitsweisen der Teilnehmer:innen nicht zum Problem werden, versuchen wir die Anzahl auf ca. 12 Personen zu begrenzen. Bei Vor-Ort-Terminen setzen wir deswegen ab 6 Teilnehmern eine:n zusätzlichen Co-Trainer:in ein, dessen Hauptaufgabe darin besteht, dich und die anderen Schulungsteilnehmer:innen entsprechend zu unterstützen, damit ihr den Schulungsinhalten weiter folgen und aufnehmen könnt.

Für die Vor-Ort-Schulungen wird Dir ein eigenes Schulungsnotebook (inkl. entsprechender Peripherie) zur Verfügung gestellt. Dieses verfügt über Internetzugriff und dient dazu, die praktischen Übungen in einer vorgegebenen Umgebung durchführen zu können. Bei vielen Schulungen arbeiten wir inzwischen nicht mehr auf den Notebooks, sondern mit virtuellen Maschinen. Dabei bekommst du (je nach Schulung) eine oder mehrere eigene VMs um dort autark in Deinem eigenen Kosmos arbeiten zu können. Bei Online-Trainings verzichten wir natürlich auf die Bereitstellung eigener Hardware, jedoch bekommst du hier mindestens eine eigene VM für die Dauer der Schulung.

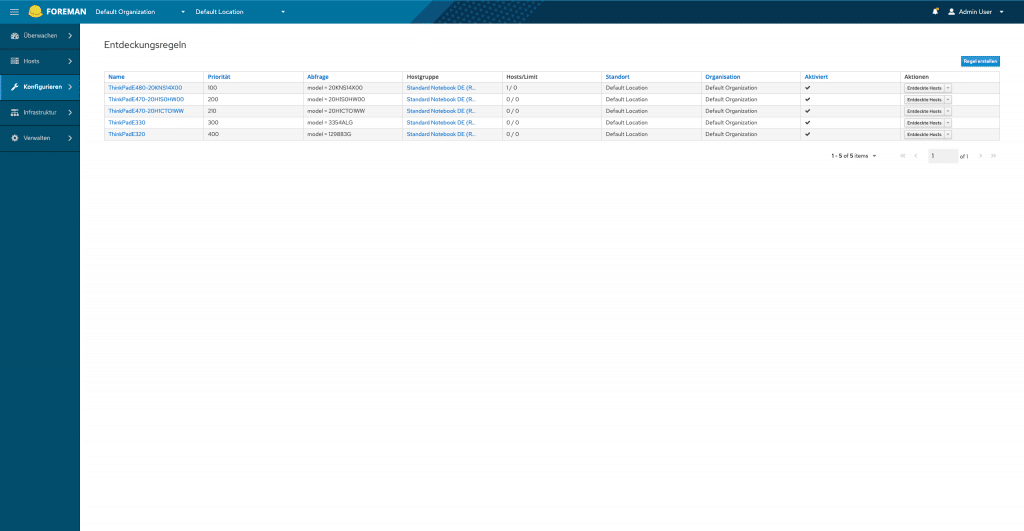

Individuelle Schulungen: wir setzen Deine Wünsche um

Neben den Schulungen an den öffentlichen Terminen bieten wir dir und deinem Unternehmen auf Bestellung auch individuell abgestimmte Schulungstermine und bei Bedarf auch auf Englisch an. Auch hier unterscheiden wir zwischen Online und vor Ort. Zu Vor-Ort-Terminen bei Kunden, sog. “Inhouse-Schulungen“. Wir bringen unser Schulungsequipment mit in Dein Unternehmen oder senden es im Vorfeld, je nach Anreise des bzw. der Trainer:innen.

So kannst du auch hier ohne Restriktionen auf dem Schulungsnotebook arbeiten. Wir mussten leider schon oft die Erfahrung machen, dass sich Teilnehmer mit eigener Hardware aufgrund von Sicherheitsvorkehrungen nicht bzw. nur mit viel Aufwand auf den Trainings-VM’s oder deren Interfaces einloggen und arbeiten konnten. Außerdem steigt die Gefahr, das die Wissensvermittlung durch Mails oder Chats unterbrochen oder zumindest gestört werden kann. Mit unserer eigenen, speziell auf das Thema vorbereiteten Hardware stellen wir sicher, das du ein funktionierendes und getestetes Notebook hast und Störfälle soweit möglich minimiert werden können.

Natürlich ist dazu bzgl. des Schulungsraumes oder benötigtem Internetzugriff im Vorfeld eine höhere Abstimmung notwendig.

Als Sonderform des NETWAYS Schulungsangebots bleiben noch individuelle Schulungen zu erwähnen. Diese stellen die absolute Ausnahme dar und werden eher selten bestellt. Eine individuelle Schulung zeichnet sich, wie der Name schon vermuten lässt, durch individuelle Schulungsinhalte aus. Das heißt, wir erstellen in deinem Auftrag die Schulung nach Deinen Themenwünschen. Da bereits eine 1-2 tägige Schulung mehrere Wochen an Vorbereitung und dem eigentlichen Schreiben der Schulung an Aufwand bedeutet, ist es natürlich eine Frage der Kosten und ob nicht doch eine Schulung aus unserem bestehenden Portfolio Kosten-Nutzen-technisch gesehen besser geeignet ist. Nicht zuletzt wollen wir bei unseren Schulungen ja sowieso bestmöglich Wissen und Best Practices vermitteln.

Eine andere, teilweise gewünschte Variante ist das Überspringen mancher Themen, das sogenannte “Picking“. Viele unserer Schulungen folgen einem bestimmten Muster und die jeweiligen Kapitel bauen aufeinander auf. Ein Weglassen eines Kapitels würde dazu führen, das auch der Rest der Schulung nicht ohne Weiteres behandelt werden kann oder zumindest Lücken im Schulungsstoff entstehen.

Vielleicht mag es für dich auf den ersten Blick sinnvoll sein, für dich eher nicht relevante Teile auszulassen, um somit die Gesamtzeit der Schulung zu kürzen, auf den zweiten Blick hat bei unseren Schulungen jedoch jedes Kapitel seine Daseinsberechtigung.

Es kann durchaus vorkommen, dass du nicht alle Teile aus einem Kapitel oder das Ganze sofort in deiner jeweiligen IT-Umgebung brauchst, es kann aber natürlich durchaus sein, das dies zukünftig mal der Fall sein wird. Zumindest lassen sich daraus auch Lösungen für ähnliche oder andere Fälle herleiten.

Erst Fundamentals dann Advanced – unsere Empfehlung

Wenn eine Schulung mehrere Level hat, z.B. “Icinga 2 Fundamentals” und “Icinga 2 Advanced” empfehlen (und erwarten) wir das du als Teilnehmer der Advanced-Schulung zuvor auch die Fundamentals-Schulung besucht hast. Die Schulungen bauen aufeinander auf und klar, in der Fundamentals-Schulung vermitteln wir auch Grundlagen, die manche Advanced-Interessenten zum teil schon haben mögen.

Durch den sehr hohen praktischen Anteil orientiert an Best Practices fehlen Ihnen aber vielleicht und erfahrungsgemäß auch einige Dinge, die wir in der Advanced-Schulung voraussetzen. Das hat zur Folge, dass der Stoff aus der Fundamentals nachgearbeitet werden muss und dieser zeitliche Mehraufwand ist in der Advanced-Schulung nicht vorgesehen. Warum wir das so handhaben? Eine regelmäßige Nachbearbeitung von Wissenslücken aus einer Grundlagenschulung würde dazu führen das andere relevante Teile nicht mit der nötigen Zeit behandelt werden können.

Und das möchten wir nicht zuletzt auch zum Wohl anderer Schulungsteilnehmer vermeiden.

Nichtsdestotrotz versuchen natürlich alle deiner individuellen Wünsche bestmöglich zu bedienen und darauf einzugehen. Unser Schulungsportfolio ändert sich von Zeit zu Zeit, weswegen wir auf bestehenden Schulungsstoff zurückgreifen können, auch wenn wir die Schulung dazu aktuell nicht auf der Webseite anbieten. Auch im Rahmen unserer internen Ausbildung haben wir einige Schulungen, die es (noch) nicht in unser offizielles Angebot und damit auf die Webseite geschafft haben.

Wenn du also den Wunsch nach einer bestimmten Schulung hast, sie aber aktuell nicht auf unserer Homepage sehen kannst, schreib uns einfach eine kurze Mail mit deinem Anliegen. In den meisten Fällen finden wir eine Lösung!

Das wichtigste Wissen kurz und kompakt – unsere Workshops

Falls eine mehrtägige Schulung deinen Zeit- oder Budgetrahmen übersteigt, haben wir eine Lösung für dich: unsere Workshops. Meistens veranstalten wir diese im Rahmen unserer Fachkonferenzen wie der Open Source Monitoring Conference oder der Stackconf.

Im Gegensatz zu unseren Schulungen gibt es für die Workshops keine ausführlich ausgefertigten Unterlagen. Stattdessen erhältst du in vielen Fällen Handouts mit den wichtigsten Eckdaten und Erkenntnissen. Dennoch folgen auch unsere Workshops einer vorgegebenen Linie. Diese kann jedoch von dir und anderen Teilnehmer:innen beeinflusst werden.

Beispiel gefällig? Das Teilnehmer:innenfeld hat bereits die Grundlagen verinnerlicht, aber spezifische Fragen zu bestimmten Aspekten einer Anwendung. Unsere erfahrenen Trainer:innen passen den Workshop an einigen Stellen auf Fragen und Wissenstand an. So kommst du immer auf Deine Kosten.

Dieser Ansatz kann bei unseren Schulungen meistens aus Zeitgründen nicht verfolgt werden. Hier kann, wenn dann nur kurz auf das zusätzliche Thema eingegangen werden.

Eine weitere Besonderheit unserer Workshops ist, dass sie ausschließlich vor Ort stattfinden. Ähnlich wie bei Schulungen setzen wir auf ein gesundes Maß an Teilnehmer:innen und setzen bei Bedarf eine:n zweiten Trainer:in ein.

Zur Open Source Enterprise Monitoring Software Icinga bieten wir derzeit jedoch keine Workshops an, andere Workshops werden im Rahmen der jeweiligen Konferenz publiziert.

Ich hoffe, ich konnte dir einen guten und vor allem spannenden Einblick in unser Schulungsangebot geben und was dich als Teilnehmer:in bei NETWAYS erwartet. Wir erweitern und aktualisieren regelmäßig unser Trainingsangebot. Ich empfehle dir also regelmäßig einen Blick auf unsere aktuelle Trainings-Webseite zu werfen. Ich bin mir sicher, dass das richtige Training für dich und deine Kolleg:innen dabei ist.

Falls du dich jetzt für ein Training interessierst oder weitere Fragen hast, zögere nicht, uns einfach eine kurze Kontaktanfrage zu schicken.