In Nürnberg standen in Oktober die Vorbereitungen und Vorfreude auf die OSMC im Vordergrund. Die Open Source Monitoring Conference ist natürlich bei NETWAYS der Höhepunkt des Herbstes, wenn nicht sogar der des ganzen Jahres. Irene bedankte sich im Blog bei den tollen Sponsoren der Konferenz.

Aber ein paar andere Themen haben uns auch beschäftigt, zum Beispiel:

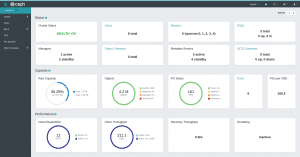

Ceph Backfilling Crash

Kubernetes 101

NETWAYS Schulungen

Und was war sonst so los?

Katja berichtete, dass das Archiv der stackconf 2023 jetzt online ist, Markus O. gab uns wieder die neuen GitHub Releases, in der Blogreihe NETWAYS Chefs könnt ihr den ersten von zwei Beiträgen vom Grillen der Azubis durchlesen (und die Rezepte nachkochen). In in der Blogreihe NETWAYS stellt sich vor könnt ihr diesmal Jolien und Cecilia kennenlernen!

Dein Wunschthema war im Oktober wieder nicht dabei? Schreib uns einfach, dann wissen wir Bescheid. Und Wünsche erfüllen wir total gerne 😊. Bis zum nächsten Mal!

Header Foto von Hari Seldon auf Unsplash