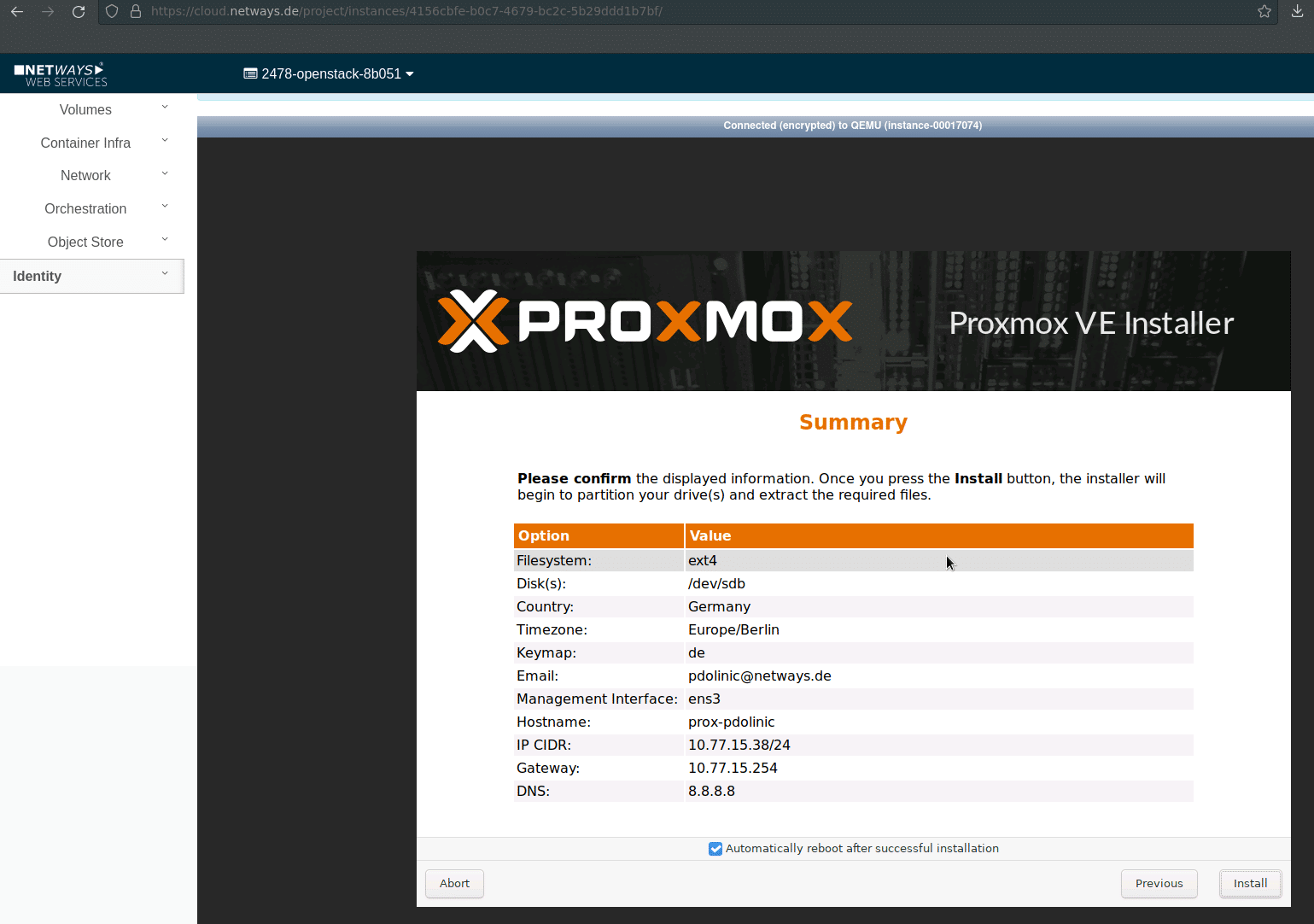

Neulich habe ich begonnen meine “Heim”-IT auf einen aktuellen Stand zu bringen. Da wir uns bei NETWAYS auch mit Proxmox Virtual Environment als Virtualisierungsplattform beschäftigen, habe ich mich ebenfalls für diese Plattform für meine drei NUC PC entschieden.

Sie bilden mit einem Ceph RBD (RADOS Block Devices) über alle drei Knoten die Basis für hochverfügbare virtuelle Maschinen oder LX Container. Für Shared Storage für Dateisysteme, z.B. für meine Nextcloud oder auch nur Zertifikate für die Web- und Mailserver ist im RBD auf Platz für mehrere CephFS.

Meine Nextcloud ist inzwischen über einige Docker Container verteilt, ich habe mich hier gegen die von Proxmox hauseigenen LXC entschieden, da ich mit Traefik als Proxy direkt auf die DockerAPI (siehe hier) zugreifen wollte, um weitere neue Webserver unkompliziert einbinden zu können. Zusätzlich versorgt mich Traefik automatisch mit benötigten Zertifikaten von Let’s Encrypt.

Kubernetes ist zwar als Technologie sehr interessant, aber meiner Ansicht nach, etwas für sehr große Umgebungen. Da ich sicherlich nicht über 200 Container hinaus komme, benutze ich Docker Swarm auf momentan drei VM. Zur Zeit ist diese Umgebung mit nur einigen Containern für die Nextcloud, Traefik und einem Webserver noch recht übersichtlich und lässt dich gut von der Kommandozeile verwalten, komme jedoch weitere Container hinzu, wird sich mit an Sicherheit grenzender Wahrscheinlichkeit auch eine webbasierte Management Console finden.

Auch durfte ich mich neulich auf der Arbeit mit SDN (Software Defined Network) im Zusammenhang mit Proxmox beschäftigen. Hiebei ging es um eine auf mehrere Standorte verteilte Umgebung, der Verbindung via VPN (hier Wireguard) und der über alle Standorte zur Verfügungsstellung eines einzigen Netzsegments. Proxmox bietet, z.Z. noch experimentell, auch hier die Konfiguration mittels GUI. Das zugrundeliegende OpenVSwitch ist aber natürlich stabil und kann notfalls auch per Hand von der Konsole in den entsprechenden Dateien eingerichtet werden.

Für mein Heimnetzwerk sicherlich zu groß gedacht, aber für den ein oder anderen vielleicht auch interessant. Bei Interesse … ihr wißt an wen ihr euch wenden könnt – NETWAYS.

So lässt sich das OpenStack Projekt bequem und übersichtlich über unser Dashboard zusammenstellen und einrichten. Der Punkt der Übersichtlichkeit führt mich auch gleich zu einem weiteren wichtigen Vorteil unseres OpenStack Angebots: Bezüglich der Kosten können wir ein maximales Maß an Transparenz bereitstellen. Es gibt keine undurchsichtigen Pauschalen und Gesamtpakete. Alle verwendeten Ressourcen werden stundengenau abgerechnet. Über unseren Cost Explorer siehst Du die für den Monat bereits entstanden Kosten und bekommst anhand der aktuell genutzten Ressourcen auch gleich eine Hochrechnung über die voraussichtliche Summe am Monatsende. Man hat die Kosten also zu jeder Zeit im Blick und kann im Bedarfsfall sofort reagieren. Das liegt auch daran, dass es keinerlei Vertragslaufzeiten gibt. Wird eine VM nicht mehr benötigt, kann man diese umgehend runterfahren. Am Monatsende zahlst Du dann nur den Betrag, der bis zu der Abschaltung entstanden ist. Das gibt Dir absolute Flexibilität in beide Richtungen – Du kannst schnell wachsen und, wenn nötig, Dein Setup auch direkt verkleinern.

So lässt sich das OpenStack Projekt bequem und übersichtlich über unser Dashboard zusammenstellen und einrichten. Der Punkt der Übersichtlichkeit führt mich auch gleich zu einem weiteren wichtigen Vorteil unseres OpenStack Angebots: Bezüglich der Kosten können wir ein maximales Maß an Transparenz bereitstellen. Es gibt keine undurchsichtigen Pauschalen und Gesamtpakete. Alle verwendeten Ressourcen werden stundengenau abgerechnet. Über unseren Cost Explorer siehst Du die für den Monat bereits entstanden Kosten und bekommst anhand der aktuell genutzten Ressourcen auch gleich eine Hochrechnung über die voraussichtliche Summe am Monatsende. Man hat die Kosten also zu jeder Zeit im Blick und kann im Bedarfsfall sofort reagieren. Das liegt auch daran, dass es keinerlei Vertragslaufzeiten gibt. Wird eine VM nicht mehr benötigt, kann man diese umgehend runterfahren. Am Monatsende zahlst Du dann nur den Betrag, der bis zu der Abschaltung entstanden ist. Das gibt Dir absolute Flexibilität in beide Richtungen – Du kannst schnell wachsen und, wenn nötig, Dein Setup auch direkt verkleinern.