![]() Nachdem im Rahmen einer wieder einmal erfolgreichen OSMC sowohl eine neue Version von Icinga 2 als auch Icinga Web 2 veröffentlicht wurde, wollen wir natürlich die Gelegenheit nutzen, diese in unseren Webinaren vorzustellen.

Nachdem im Rahmen einer wieder einmal erfolgreichen OSMC sowohl eine neue Version von Icinga 2 als auch Icinga Web 2 veröffentlicht wurde, wollen wir natürlich die Gelegenheit nutzen, diese in unseren Webinaren vorzustellen.

Die Termine im Dezember stehen bereits fest und wir freuen uns wie immer auf eine rege Teilnahme zum Abschluss dieses erfolgreichen Jahres!

| Titel | Zeitraum | Registrierung |

|---|---|---|

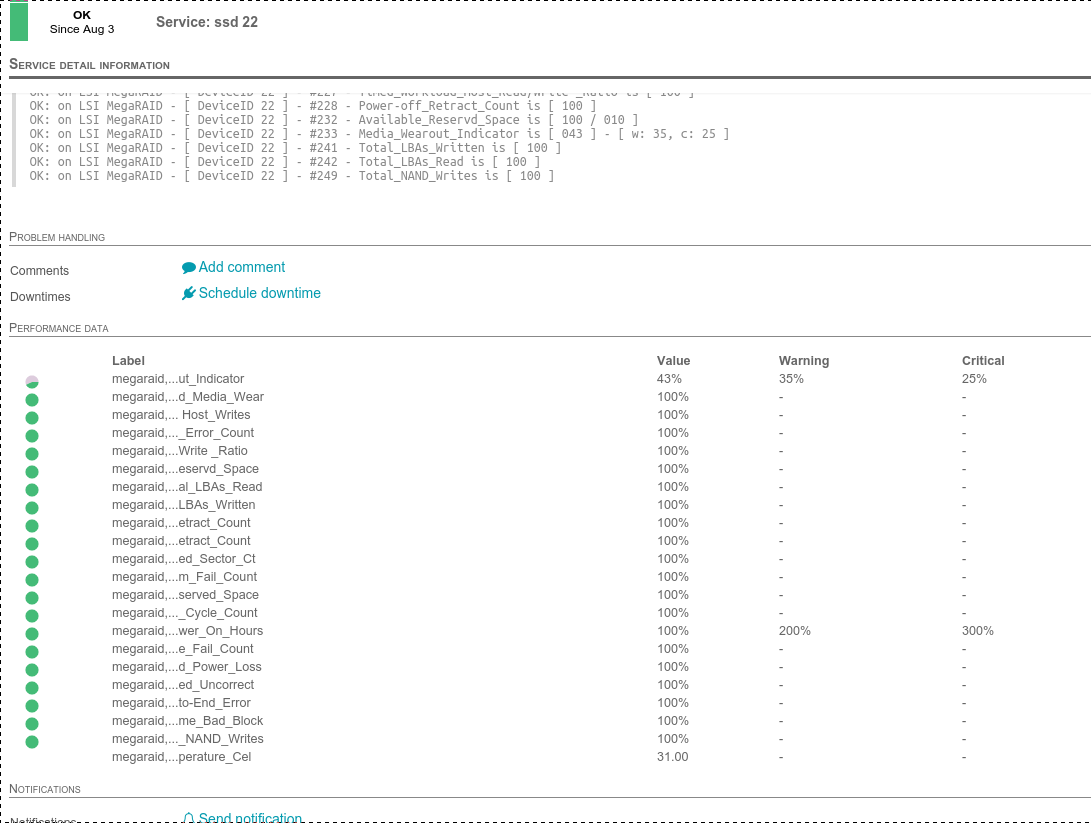

| Icinga 2 – Neues in 2.4 | 08. Dezember 2015 – 10:30 Uhr | Anmelden |

| Icinga Web 2: Das neue Interface | 09. Dezember 2015 – 10:30 Uhr | Anmelden |