OSMC 2021 has brought many insights into latest monitoring trends and we’re still amazed about that great on-site event last autmn. We’re happy to had a big amount of international attendees, 28 top-level speakers and not to forget our much valued sponsors on bord – in short: we’re grateful for everyone who made OSMC 2021 a special and an exciting event once again!

For all of you who would like to listen to last year’s experts sessions as a follow-up, I’ve created this blog series. It reminds you bi-weekly of one of our OSMC lectures including its video recording.

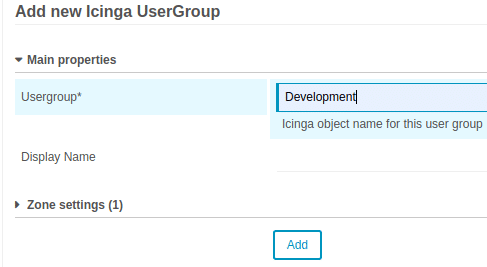

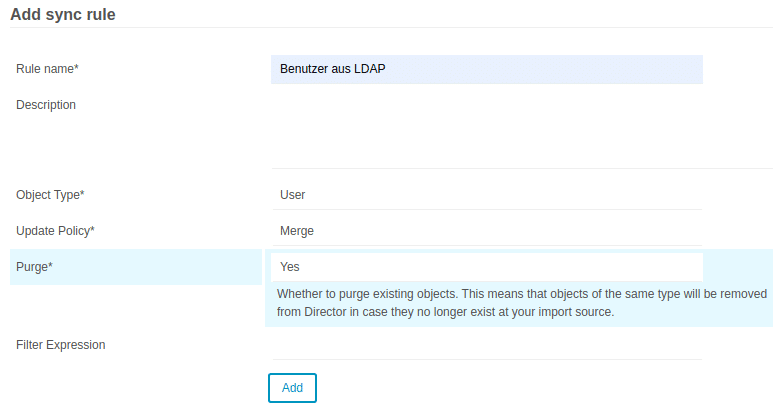

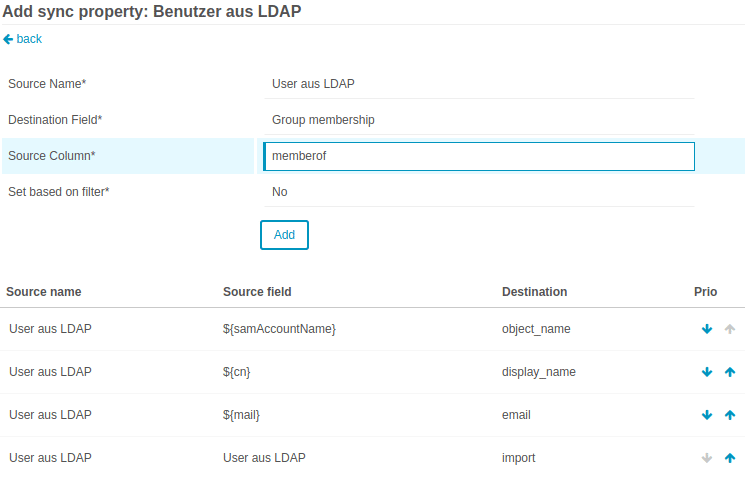

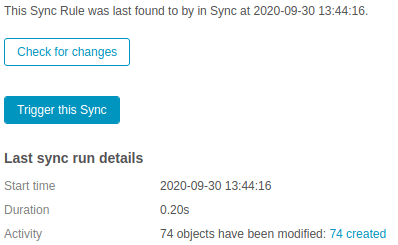

Today it’s all about Daniel Uhlmann and Sebastian Gumprich with their talk „Still directing the director… and more!“ Daniel and Sebastian tell you how they automated the monitoring of their services using their self-written Ansible collections.

Enjoy their lecture!

OSMC 2022 is just around the corner! Get one of our last tickets for the event and join us from November 14-16.

We’re looking forward to meeting you all again this autumn in Nuremberg.