Hallo Liebe Leser dieses Blogs,

nach einer weile der Abwesenheit hab ich heute die Freude ihnen etwas näher bringen zu dürfen.

Da viele unserer Kunden inzwischen auch ServiceNow verwenden und diese auch als Assetmanagement / CMDB verwenden.

Kommt doch die Frage auf wie man gegebenenfalls hier die Daten abfragen kann um Sie in den Director zu importieren um daraus dann Hosts/Services zur Überwachung zu formen.Ich versuche in diesem kleinen Blogpost zumindest einen Ansatzpunkt hierzu aufzuzeigen. Viele verwenden in diesem Fall ja ServiceNow als SaaS, aber es gibt auch Kunden welche es als On Prem einsetzen.

Aber fangen wir an 🙂 in diesem Fall ist der Anlaufpunkt hier die ServiceNow API, wer hätte es gedacht.

In diesem Fall ziehe ich mal die folgende API (Link) zur rate:

Hier wird die ‚cmdb-instance‘ in welcher die CMDB Daten landen dokumentiert. Es ist aber zu bedenken, dass die Instanz natürlich abweichen kann daher ist dies bitte nicht direkt 1:1 zu übernehmen.

Wir feuern per curl gegen die ServiceNow API, die folgende Abfrage… in Hoffnung, dass wir valides JSON zurückerhalten mit all unseren Objekten.

curl -k -s -S -i -u 'servicenow_apiuser:servicenow_apiuserpassword' -H 'Accept: application/json' -H 'X-HTTP-Method-Override: GET' -X POST 'https://instance.servicenow.com/api/now/cmdb/instance/cmdb_ci_linux_server'

und wir erhalten als Antwort das folgende JSON:

{

"result": {

...

"attributes": {

"firewall_status": "Intranet",

"os_address_width": "",

"sys_updated_on": "2020-07-08 11:16:51",

"sys_created_by": "glide.maint",

"warranty_expiration": "",

"ram": "2048",

"cpu_name": "",

"cpu_speed": "2800",

"classification": "Production",

"disk_space": "40",

"dns_domain": "",

"assigned": "2020-01-04 07:00:00",

"floppy": "",

...

"sys_class_name": "cmdb_ci_linux_server",

...

"cpu_count": "1",

...

"os_version": "2.6.9-22.0.1.ELsmp",

"serial_number": "",

"attributes": "",

...

"form_factor": "",

"cpu_core_count": "",

"sys_updated_by": "system",

"sys_created_on": "2008-10-26 17:17:28",

...

"name": "PS LinuxApp01",

"default_gateway": "",

"chassis_type": "",

"sys_id": "3a290cc60a0a0bb400000bdb386af1cf",

"po_number": "",

"checked_in": "",

...

"comments": "",

"os": "Linux Red Hat",

"sys_mod_count": "24",

"monitor": "false",

"model_id": {

"display_value": "Iris 5875",

"link": "https://instance.servicenow.com/api/now/table/cmdb_model/5f5fbcc3c0a8010e00f3b27814f3b96b",

"value": "5f5fbcc3c0a8010e00f3b27814f3b96b"

},

"ip_address": "192.168.178.1",

"duplicate_of": "",

"location": {

"display_value": "Somewhere Street, Someplace, State",

},

"category": "Do not migrate to asset",

"fault_count": "0",

"host_name": "",

"lease_id": ""

},

}

Den Output schreiben wir als Datei raus, so dass wir hier als Beipiel eine Datei haben, mit der wir weiterarbeiten können. Als Beispiel nennen wir diese servicenow.json

(Exclaimer) Ich habe das JSON hier als Beispiel mal extrem zusammengekürzt, damit wir thementechnisch nicht zu weit Abdriften.

Anyway, aber damit lässt sich arbeiten.

Damit wir mit diesem JSON arbeiten können, verwenden wir das Tool ‚jq‘, um relevante key/value Paare herauszufiltern.

Ich habe hier mal den folgenden ‚jq‘ Aufruf verwendet:

jq -j '.result.attributes.os,",",.result.attributes.ip_address,",",.result.attributes.classification,",",.result.attributes.sys_class_name,",",.result.attributes.name,",",.result.attributes.location.display_value,","' servicenow.json

Der somit gewonnene Output ist der folgende, bitte beachtet die ‚,‘ Kommata. Die meisten werden schon ahnen worauf ich gleich hinaus will.

Zurück zu dem nun mit ‚jq‘ aufbereiteteb Output, dieser ist der folgende:

Linux Red Hat,192.168.178.1,Production,cmdb_ci_linux_server,PS LinuxApp01,Somewhere Street, Someplace, State,

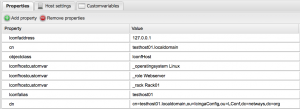

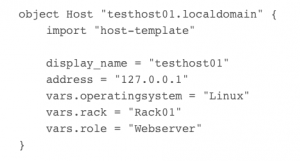

Mit etwas Bash Scripting kann man das schön automatisieren und hat am Ende dieses Vorgangs eine CSV Datei, die man hervorragend im Director per Fileshipper weiterverarbeiten kann.

Das mit dem CSV ist eine Geschmacksfrage, denn man kann auch direkt JSON per Fileshipper importieren … ich würde aber dazu tendieren, die Datenmenge durch etwas vorfiltern zu verkleinern. So eine Filterung, wie gesehen, kann auch per ‚jq‘ erfolgen, so dass man ein kleineres JSON File erhält.

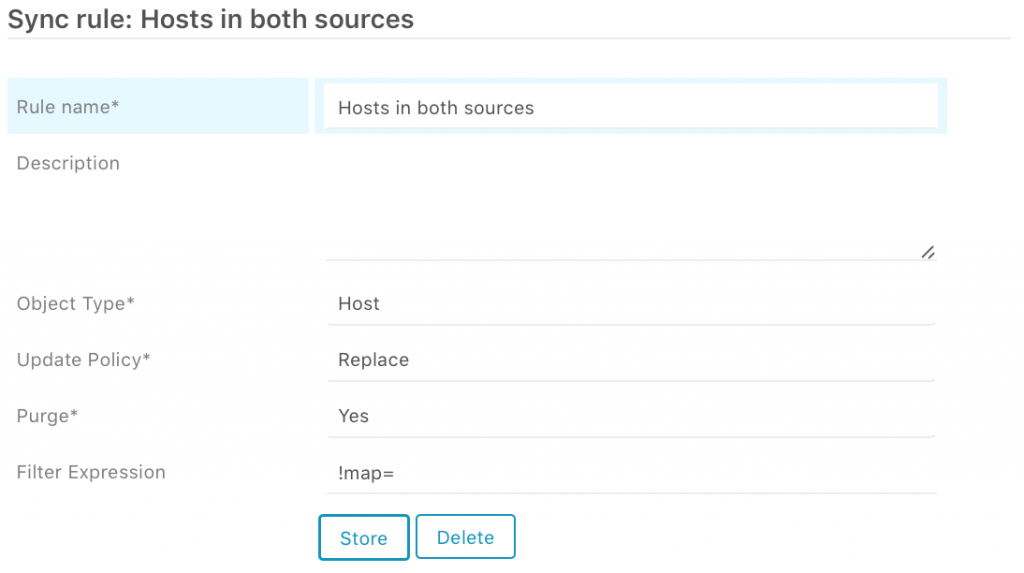

Wer wissen möchte, wie man mit dem Director einen Fileshipper-Import durchführt, dem sei der Blogpost meines Kollegen Johannes empfohlen.

Blogpost Director Fileshipper Import

Das war schon mein kleines Intermezzo wie ServiceNow-Data-Assets per Fileshipper in den Director zu importiert sind.

Bis zum nächsten Mal

Mit freundlichem Gruß

David