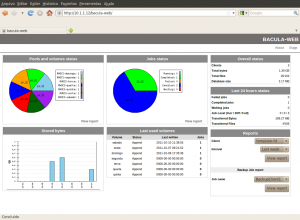

Seit einiger Zeit ist eine neue Version der Web Gui „Bacula-Web“ für Bacula erschienen.

Bacula-Web ist ein Open Source Tool, welches ein Teil des Bacula Projectes ist.

Mit dieser Oberfläche ist es zwar nicht möglich Jobs zu steuern, aber man kann sich dafür

viele Informationen über Jobs, Volumes und Pools übersichtlich anzeigen lassen.

Die Installation und Konfiguration ist schnell durchgeführt, was ein Ausprobieren

sehr einfach macht.

Für die Installation benötigt man lediglich einen Webserver mit PHP Modulen

(Howto) und eine laufende Bacula Director Datenbank egal ob MySQL, postgreSQL oder SQLite.

Leider bin ich heute auf einen Fehler gestoßen, der mit der neusten Version 5.2.10 und

postgreSQL auftritt. Der Bug ist bekannt und ich hoffe, dass dieser schnell behoben wird.

Trotzdem lohnt sich das Ausprobieren auf jeden Fall.