Mit Windows 8.x und den Server-Versionen 2012 (R2) hat Microsoft standardmäßig die Installation von nicht signierten Treibern verboten, um die Stabilität des Systems sowie die Sicherheit zu erhöhen. Wer unser CEP CT63 Terminal USB Powered oder CEP CT63 GSM USB/Seriell Starter auch unter den neuen Windows Versionen zum SMS-Versand nutzen will, stößt daher anfänglich auf einige Schwierigkeiten – die Treiber sind nämlich nicht digital signiert und daher nicht installierbar.

Mit Windows 8.x und den Server-Versionen 2012 (R2) hat Microsoft standardmäßig die Installation von nicht signierten Treibern verboten, um die Stabilität des Systems sowie die Sicherheit zu erhöhen. Wer unser CEP CT63 Terminal USB Powered oder CEP CT63 GSM USB/Seriell Starter auch unter den neuen Windows Versionen zum SMS-Versand nutzen will, stößt daher anfänglich auf einige Schwierigkeiten – die Treiber sind nämlich nicht digital signiert und daher nicht installierbar.

Um die Treiberinstallation auf diesen Windows-Versionen dennoch zu erlauben, muss Windows mit deaktivierter Treibersignaturprüfung gestartet werden. Und so gehts:

Step 1: Sytem im Auswahlmodus neu starten

1. Windows-Taste + i drücken

2. Auf „Ein/Aus“ klicken

3. Windows mit gedrückter SHIFT-Taste „Neu starten“

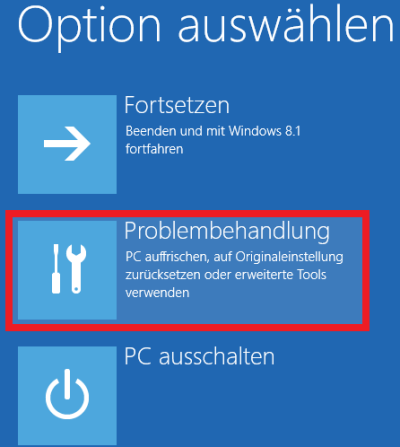

Step 2: In den Optionen „Problembehandlung“ auswählen

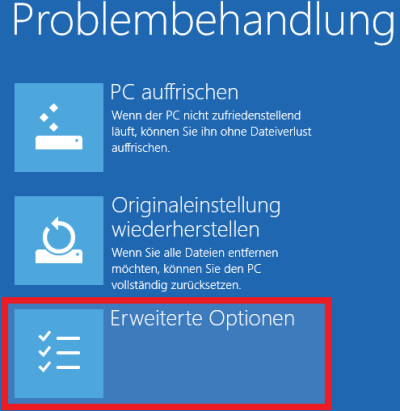

Step 3: „Erweiterte Optionen“ öffnen

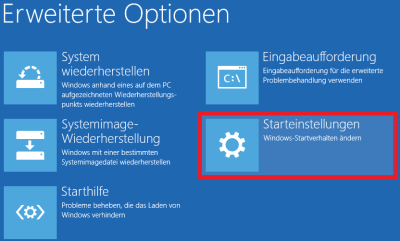

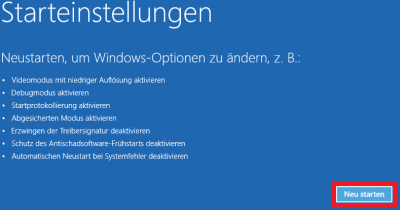

Step 4: „Starteinstellungen“ öffnen

Step 5: „Neu starten“ anklicken

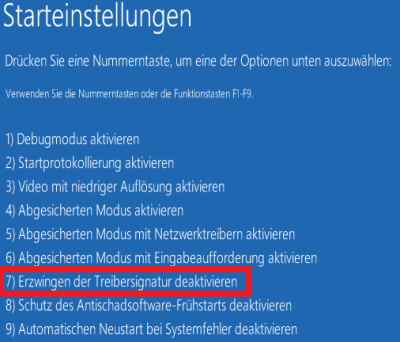

Step 6: „Erzwingen der Treibersignatur deaktivieren“ mittels der Taste 7 oder F7

Nun kann der Treiber ohne Probleme auf dem System installiert werden.

Natürlich haben wir auch eine Vielzahl von SMS-Gateways, welche treiberunabhängig sind und über das Netzwerk gesteuert werden können. Einfach mal in unserem Online Store reinschauen.

Fragen?

Dann einfach direkt Kontakt aufnehmen. Wir helfen gerne weiter!