Wir bei Netways setzen bekanntermaßen sehr gerne und mit großen Eifer OpenSource-Lösungen auch in unserer Infrastruktur ein. Hierbei greifen Puppet, Foreman und OpenNebula auf ein gemeinsames Rückgrat zu, unseren Storage, der aktuell auf zwei Standorte und insgesamt 18 Server verteilt ist.

Dieser wird mittlerweile seit mehreren Jahren über Ceph zur Verfügung gestellt.

Ceph wurde 2007 von Sage Weil im Rahmen einer Doktorarbeit entwickelt und stellt ein Konzept für einen Object Store dar, der verteilt, hochverfügbar und auch eine konfigurierbare Anzahl an Replica skalierend vorhalten kann.

Seit dem ersten Stable Release 2012 hat sich das Ceph Projekt steil nach oben entwickelt , was 2014 zur Übernahme durch Red Hat führte. Trotz des hausinternen Konkurrenz durch GlusterFS steht die Entwicklung bei Ceph nicht still, sondern hat sich im Gegenteil beschleunigt.

Seit Version 0.6 Mitte 2012 ist Ceph innerhalb von 4 Jahren bei der vierten LTS Version „Hammer“ angekommen und wird in unterschiedlichen Clustergrößen bei den unterschiedlichsten Organisationen eingesetzt. Während unser Produktivcluster ca. 300 TB verwaltet, setzte das CERN bereits 2013 einen Testcluster von 3 Petabyte (sic!) ein.

Über die Jahre der Administration und des Einsatzes eines Clusters eignet man sich selbstverständlich ein gewisses Maß an Wissen an. Neben Veranstaltungsbesuchen und Vorträgen von externen Referenten, versuchen wir seit diesem Jahr, Ceph auch mit Schulungen von unserer Seite aus bekannter zu machen.

In der zweiten Iteration fand diese letzte Woche im 2tägigen Rahmen statt.

Neben der Wissensvermittlung stand auch die Netways-berühmtberüchtigte Nahrungsmittelüberversorgung mit Frühstück, Kaffeepause I, Mittagessen, Kaffeepause II und Abendessen für die Teilnehmer auf dem Programm.

Als Einstieg wählte Trainer Achim Ledermüller einen Überblick auf verschiedene Storage Arten um in der Folge Ceph genauer vorzustellen. Praktische Anwendung kam natürlich nicht zu kurz.

Die Teilnehmer installierten ihren eigenen Ceph-Cluster auf den bereitgestellten Schulungsnotebooks und konnten nach kurzer Zeit gegenseitig die ersten Dateien in rados-pools ablegen und aufrufen.

Als nächster Punkt wurde der Algorithmus hinter Ceph, „CRUSH“ und die zur Clusterverwaltung eingesetzte crushmap erklärt und an praktischen Beispielen veranschaulicht. Wie verändert sich der Cluster, wenn ein OSD ausfällt oder nach langer Zeit wieder in den Cluster zurück kehrt?

Nach einer kurzen Feedbackrunde ging es zu dem oben erwähnten Abendessen in das gewohnt gute Gasthaus Pegnitztal wo auch nicht-Ceph-Themen diskutiert wurden.

An Tag 2 hatten die Teilnehmer die Möglichkeit, eigene VMs mit QEMU/KVM auf dem Storage zu deployen, und die Auswirkungen auf den Cluster live zu beobachten.

Der restliche Tag stand im Zeichen der praktischen Anwendung.

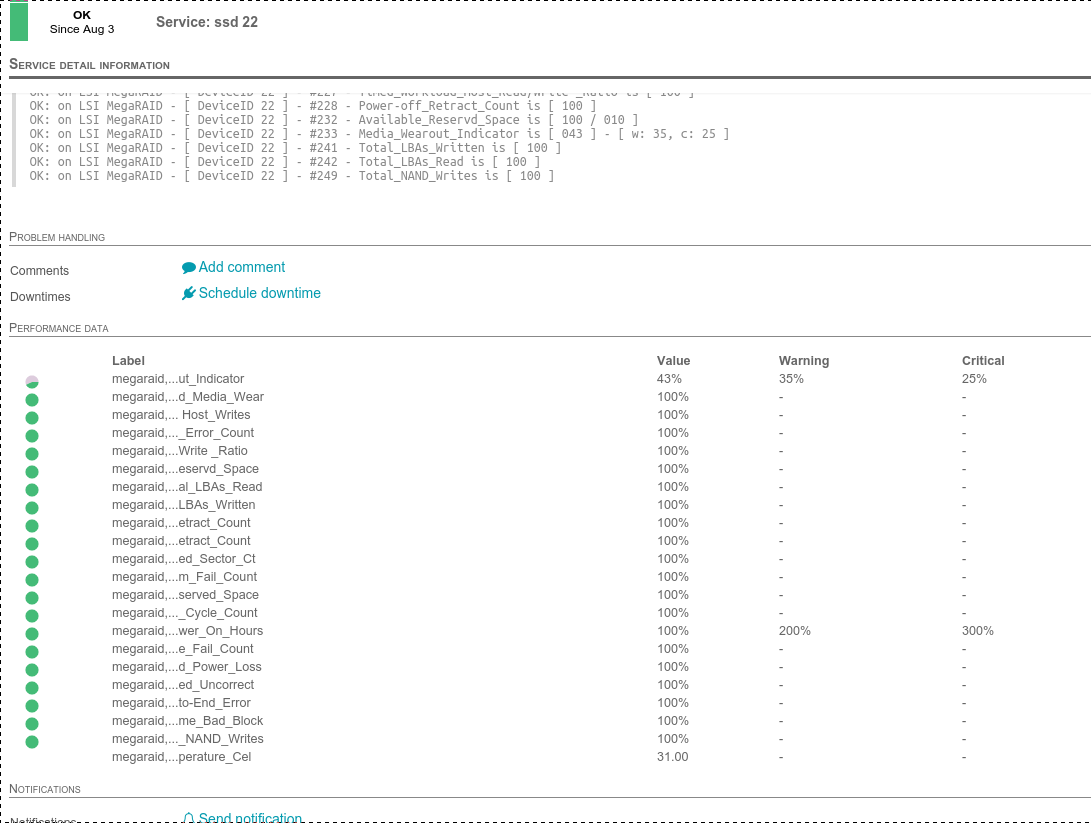

Wie sieht es mit der Kompatibilität zur S3 API aus (gut!), welche Hardware ist Best Practice (commodity), wo kann ich an Performanceschrauben drehen (Netzwerk, storage und caching)? Wie kann ich den Cluster überwachen (ceph-plugins) und was ist im Fehlerfall zu tun?

Die nächsten Schulungstermine finden sich hier, wir würden uns freuen, unser Wissen weiterhin mit anderen zu teilen.

Der letzte Ceph Major Release Jewel hat nicht nur viele Bugs behoben sondern auch neue Features eingeführt bzw. für die Produktion freigegeben.

Der letzte Ceph Major Release Jewel hat nicht nur viele Bugs behoben sondern auch neue Features eingeführt bzw. für die Produktion freigegeben.