This year’s stackconf is over and was a big success. The three-day conference last summer was all about open source infrastructures where trendsetting concepts, state-of-the-art technical expertise, top-level discussions and new perspectives have shaped the event.

Besides our 30 amazing experts sessions we were also excited about the large amount of participants from all over the world. Our audience included renowned infrastructure spezialists, industry leaders, experienced administrators and IT architects as well as a wild bunch of open source community enthusiasts.

For all of you who couldn’t join the Open Source Infrastructure Conference I’ve something awesome today.

Matt Jarvis told us in his lecture to ensure our apps and platforms are secure. It’s important to integrate security at all stages of pipelines and to ensure that developers and engineering teams have tools and data with enable them to make decisions about security on an ongoing basis. In his session he talked through the problem space, looked at the kinds of security issues needed to consider, and looked at where the integration points are to build in security as part of the CI/CD process.

Enjoy his lecture!

stackconf 2022 will take place from May 16-17 in Berlin. We’re already looking for speakers sharing their expertise on open source infrastructure solutions. Lectures focussing on topics around the whole lifecycle like building, CI/CD, running and monitoring are very appreciated. Submit your proposal until February 15 and feel free to contact us in case you have any questions.

We are already looking forward to meeting you all again in person this year.

If you want to learn more about infrastructure solutions in advance always keep in mind that there’s our archive where you can find all slides and videos of every stackconf speaker.

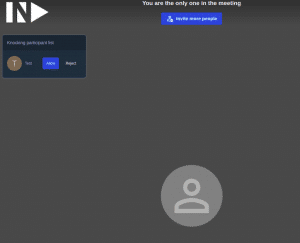

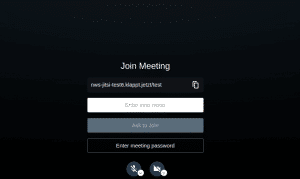

If you use names like „test“ or „foobar“, it is easy to join your rooms and disturb you and your attendees.

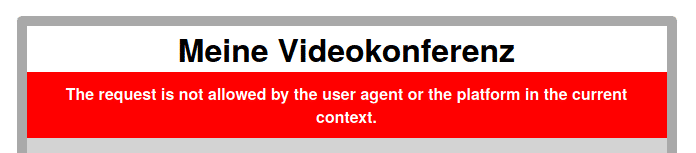

If you use names like „test“ or „foobar“, it is easy to join your rooms and disturb you and your attendees. To secure your Jitsi even more, we have another feature ready for you.

To secure your Jitsi even more, we have another feature ready for you.