Bei einem Consultingkunden hatte ich eine interessante Aufgabenstellung zu lösen: “Jedes Mal wenn die Domänencontroller geplant nacheinander durchgestartet werden führt das dazu, dass die Hosts im Monitoring (Icinga) kurzzeitig nicht erreichbar sind”. Auf die Frage warum die Domänencontroller regelmäßig durchgestartet werden möchte ich übrigens nicht näher eingehen 😉

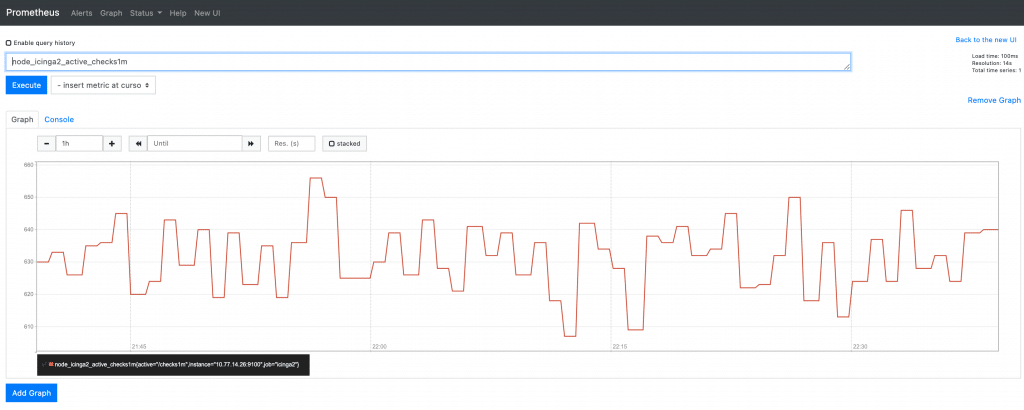

Nach etwas Recherche hat sich dann herausgestellt dass das Problem aller Wahrscheinlichkeit nach am DNS liegt. Dazu sollte man wissen das die DNS-Auflösung über das sog. Resolver Configuration File die Datei “/etc/resolv.conf” bei mehreren Einträgen sequenziell läuft. D.h. das immer versucht wird über den zuerst eingetragen Nameserver aufzulösen, sollte das nicht funktionieren wird nach Erreichen des Timeouts (standardmäßig 5s) der nächste Eintrag probiert usw.

Was also tun? Den herkömmlichen Mechanismus zur DNS-Auflösung einfach ersetzen! Eine elegante und einfach zu installierende Alternative ist dnsmasq. Das Tool bietet zwar noch ein paar weitere Möglichkeiten, in meinem Fall reicht es aber schon aus das dnsmasq die Nameserver parallel befrägt (all-servers) und den nimmt, der am schnellsten antwortet. Am Beispiel von CentOS 7 lässt sich dnsmasq als Plugin über den Network Manager aktivieren. Dazu hinterlegen wir zuerst einmal die Hauptkonfiguration von dnsmasq in der Datei “/etc/NetworkManager/dnsmasq.d/dnsmasq.conf”:

resolv-file=/etc/resolv.dnsmasq all-servers interface=lo bind-interfaces cache-size=0

Danach übertragen wir die beispielhaften Nameserver aus “/etc/resolv.conf” nach “/etc/resolv.dnsmasq”:

nameserver 8.8.8.8 nameserver 8.8.4.4

Ist das passiert können wir im Network Manager über “/etc/NetworkManager/conf.d/dns.conf den DNS-Modus ändern:

[main] dns=dnsmasq

Noch kurz den Network Manager neu laden:

systemctl reload NetworkManager.service

Und schon kommen wir in den Genuss der Auflösung via dnsmasq. Dabei ist zu beachten das der Network Manager die bisherigen Namerserver-Einträge in der “/etc/resolv.conf” entfernt und gegen lediglich einen Eintrag auf “127.0.0.1” ersetzt hat.

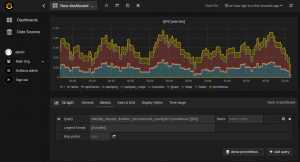

Beim betroffenen Kunden funktioniert die Lösung mit dnsmasq seit einigen Monaten zuverlässig und das auch wenn die Domänencontroller mal wieder durchgestartet werden. Und natürlich würde es mich freuen wenn wir auch Ihr Problem lösen können!