Im ersten Teil ging es um das Grillgut und die Salate, in diesem zweiten Teil zeigen wir Dir Rezepte für Ciabatta und Foccacia, Tzatziki und Hummus sowie den Nachtisch, den wir gereicht haben.

Focaccia von Dirk Götz

Tatsächlich bin ich durch den Lockdown dazu übergegangen, relativ häufig Brot selbst zu backen. Da ich privat meist nicht so weit vorplane wie dienstlich, werden gerade schnelle Rezepte dabei öfter gebacken. Das Focaccia-Rezept von Chefkoch ist so eines, da in gut anderthalb Stunden zwei Fladen essbereit sind. Auch lässt sich das Rezept leicht verdoppeln oder, wie bei diesem Grillen, gleich vervierfachen. Zusätzlich zu den Originalzutaten belege ich es gerne mit Tomaten und Oliven.

Du brauchst (für zwei Fladen):

400g Mehl

1 Päckchen Trockenhefe

250ml Milch

75ml Olivenöl

1 TL Salz (gehäuft)

1 TL Knoblauchgranulat (gestrichen)

2 TL Oregano

Olivenöl zum Bestreichen

Salz zum Bestreuen

Oregano zum Bestreuen

3 Zehen Knoblauch zum Bestreuen

Ein paar Kirschtomaten, grüne Oliven, Kalmata-Oliven

So geht’s:

Aus den ersten 7 Zutaten einen Teig kneten und in einer verschlossenen Schüssel gehen lassen. Je nach Temperatur empfiehlt sich ein Warm-Wasserbad. Der Teig geht dabei deutlich auf. Nebenbei den Knoblauch hacken.

Den Teig dann nach ca. 45 Minuten halbieren und zu zwei Fladen formen. Diesen mit den Fingerspitzen eindrücken, mit Öl einpinseln, salzen, mit Oregano und dem gehackten Knoblauch bestreuen. Die Tomaten und Oliven in Scheiben schneiden und leicht in den Teig drücken.

Nun 20 Minuten bei 175°C Umluft backen bis es leicht gebräunt ist.

Ciabatta von Valeria Thiele

Natürlich darf ein leckeres Ciabatta bei einer Grillparty nicht fehlen. Hier komme ich ins Spiel.

Daheim hatte ich schon ein paar mal mit meinem Freund zusammen Ciabatta gebacken. Na gut, eigentlich habe ich eher assistiert :D. Dies ist immer sehr gut geworden und daher wollte ich es für NETWAYS nachbacken. Das Rezept, an dem ich mich orientiert habe, könnt ihr bei Thomas kocht nachlesen.

Du brauchst:

400g Mehl (Typ 550), sowie Mehl für die Arbeitsfläche

4g frische Hefe

8g Salz

300ml Wasser

Öl zum Einfetten

Außerdem wird hierfür eine Schüssel benötigt worin der Teig gehen kann, sowie eine große Schale worin man den Teig falten kann, im besten Fall eine Teigwanne.

Insgesamt haben wir 8 Ciabatta gebacken.

So geht`s:

Schritt 1

Begonnen habe ich am Vorabend, damit der Teig über Nacht gehen konnte.

Ich habe jeweils den Teig für 2 Ciabatta in einer Schüssel gemacht:

Wasser in eine Schale geben und die Hefe darin gut auflösen. Salz und Mehl in einer Schüssel vermischen. Das Hefewasser zugeben und so lange vermischen, bis alles Mehl gebunden ist.

Insgesamt brauchte ich also 4 Schüsseln, da ich keine 8 Ciabatta gleichzeitig händeln kann. So konnte ich die Teige nach und nach abarbeiten. Gebacken haben wir 4 normale Ciabatta und 4 mit mediterranen Gewürzen.

Für das mediterrane Ciabatta habe ich noch nach Belieben Thymian, Rosmarin, Oregano und getrocknete Tomaten hinzugefügt.

Schritt 2

Am nächsten Morgen habe ich zunächst 2 Schüsseln aus dem Kühlschrank genommen, um den Teig bei Zimmertemperatur gehen zu lassen.

Nach ca. 1 Stunde habe ich dann auch die nächsten 2 Schüsseln aus dem Kühlschrank genommen. Der Teig kann verarbeitet werden, wenn er viele Blasen wirft, er sollte jedoch mind. 2 Stunden bei Zimmertemperatur gehen.

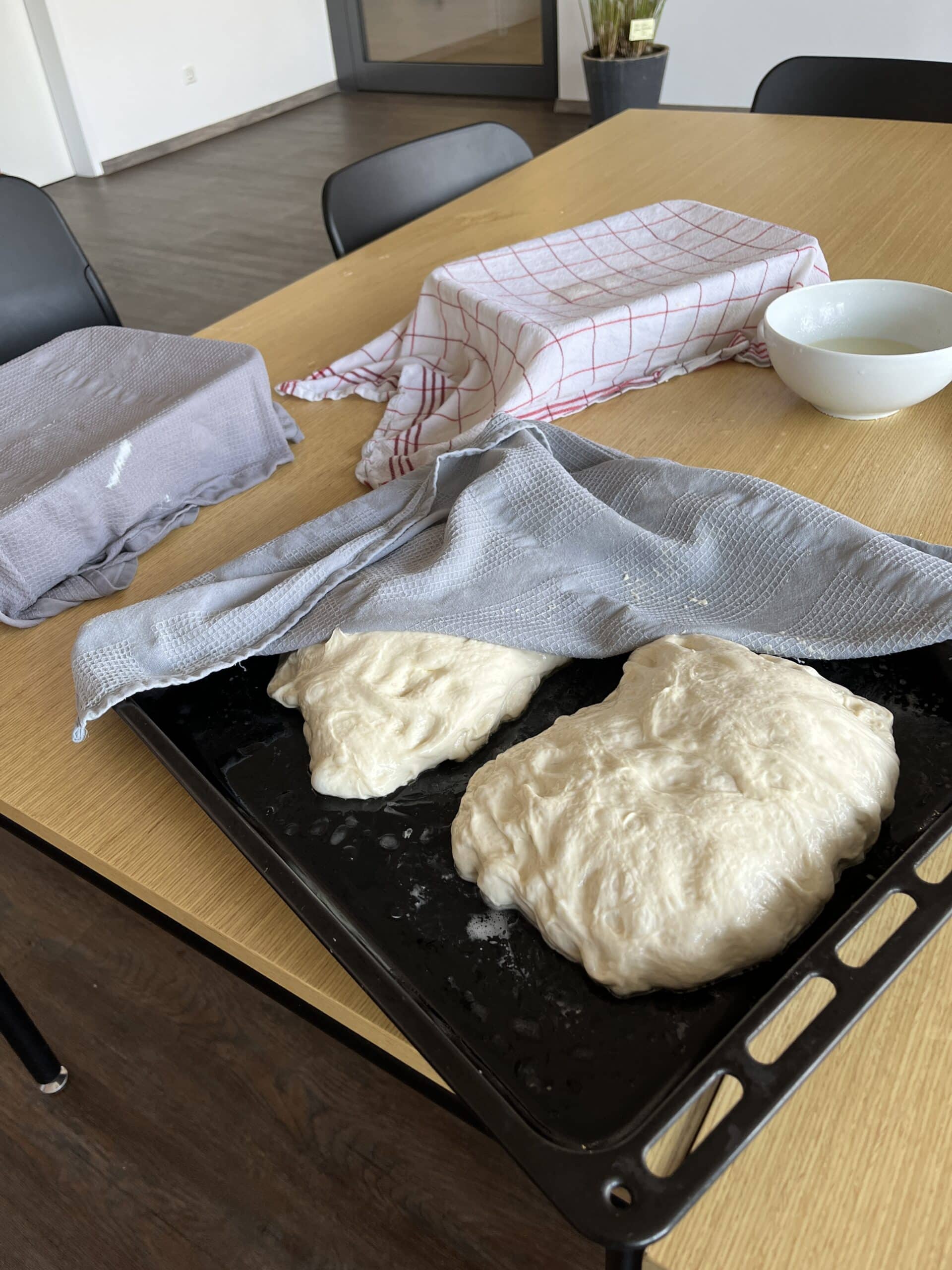

Schritt 3

Den Teig aus einer Schüssel auf ein gut geöltes Blech legen. Danach hieß es eigentlich nur noch, den wabbeligen Teig zu falten und 15 min warten, wieder falten und warten, immer und immer wieder, 4-6 mal für alle Ciabattas. In den Ruhezeiten sollten der Teig mit einem feuchten Tuch abgedeckt werden. Insbesondere das Falten ist für jemanden, der das noch nicht gemacht hat, schwierig und man sollte sich vorher unbedingt das Originalrezept und das Video dazu anschauen. Auch für mich war es hier schwierig, da der Teig etwas zu ölig wurde und dadurch der Teig sich beim Falten immer wieder öffnete.

Hat man das jedoch geschafft ist der schwerste Teil überstanden.

Schritt 4

Der Teig kann nun halbiert werden und zu einem Baguette geformt werden. Bevor es in den Ofen kann, muss der Teig noch einmal 30 min gehen.

Schritt 4

Ofen vorheizen auf 240 C° Ober-Unterhitze und für ca. 20 Minuten ohne Dampfzugabe backen. Die Zeit kann natürlich je nach Ofen und Größe der Ciabatta variieren.

Fazit

Wer es schon mal gemacht hat, weis, dass der Teig nicht einfach zu händeln ist. Es war eine äußerst wabbelige Angelegenheit.

Das Endergebnis war ein super luftiger Teig, doch ganz zufrieden war ich nicht. Die krosse Kruste habe ich nicht hinbekommen. Dennoch wurde es von allen gern gegessen, was mich sehr gefreut hat.

Hummus von Valeria Thiele

Was passt gut zu Ciabatta? Richtig, Hummus! Und hier ist mein persönliches Hummus-Rezept:

Du brauchst (für eine große Schüssel):

3 Dosen Kichererbsen (265 g)

300 ml eiskaltes Wasser

Saft von 3 Zitronen

1-2 TL Salz

1-2 TL Kreuzkümmel

ggf. Kurkuma

360g Tahin

3 Knoblauchzehen

So geht`s:

Zunächst wird der Zitronensaft, der Knoblauch und das Salz in einer Schüssel mit dem Mixer püriert. Danach wird das Tahin in die Schüssel gegeben. Alles durchmixen und gleichzeitig das kalte Wasser beim Mixen zugießen, so wird der Hummus besonders luftig.

Zum Schluss noch das Olivenöl und die Gewürze hinzufügen und nochmals durch mixen. Und fertig!

Ein 5-Minuten-Rezept, welches am besten zu frischem Brot passt.

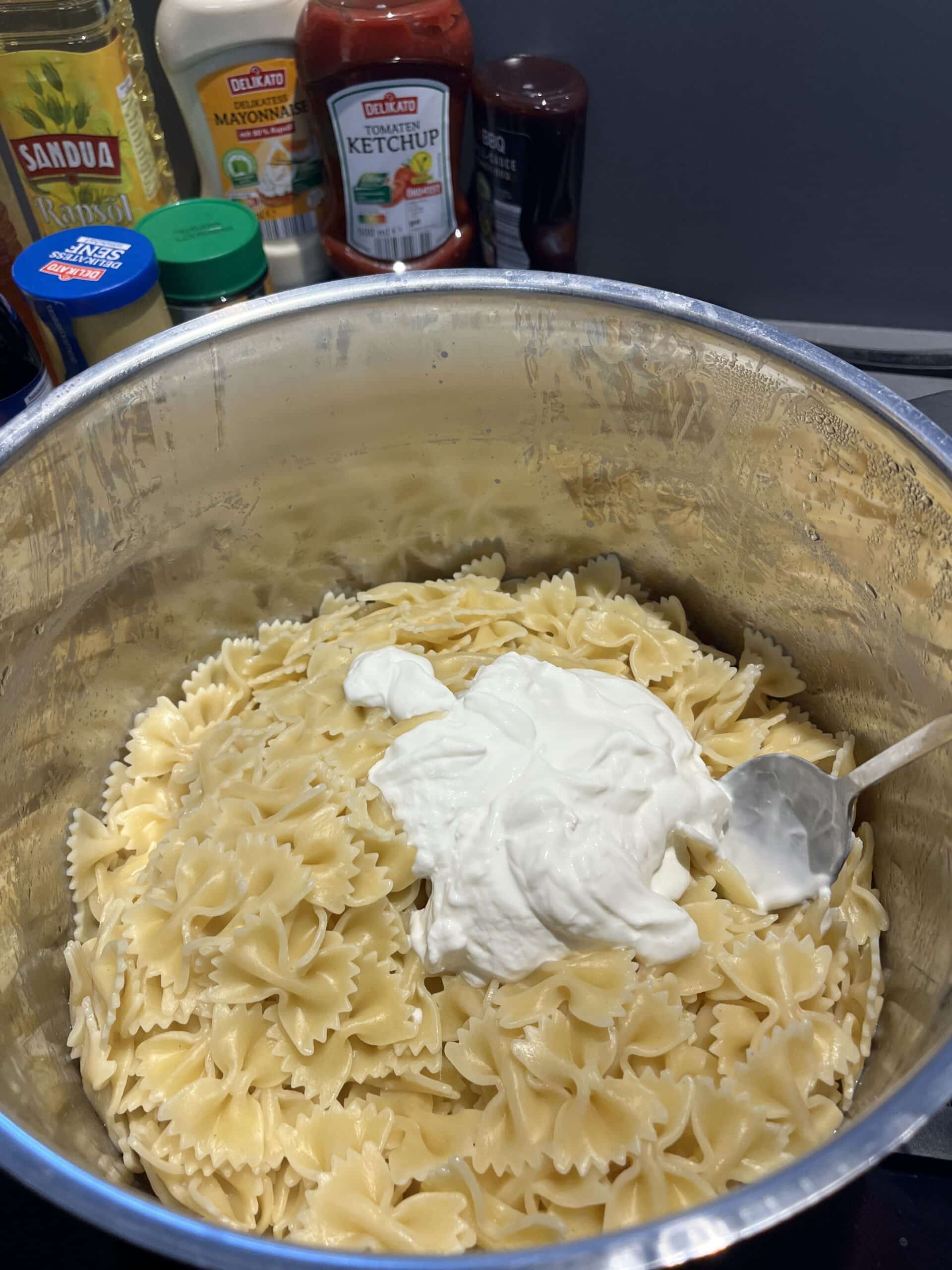

Tzatziki von Apostolos Pliakos

Als Grieche war es für mich eine Selbstverständlichkeit, den Tzatziki zuzubereiten. Das Geheimnis eines hervorragenden Tzatzikis liegt zweifellos im hochwertigen griechischen Joghurt. Daher habe ich mir die Zeit genommen, zu einem authentischen griechischen Großhändler zu fahren, um nur das Beste für meine Kollegen zu besorgen. Das Rezept kommt von akispetretzikis.com

Du brauchst:

300g Joghurt

1 Gurke

1/3 Knoblauchzehe

3 EL Weißweinessig

1/4 Bund Dill

2 EL Olivenöl

1 Prise Salz

Pfeffer

So geht`s:

Die Zubereitung beginnt mit dem Schälen der Gurke und dem groben Reiben mit einer Käsereibe. Die Gurke wird dann in eine Schüssel gegeben, in der sie mit einer Prise Salz und einem Esslöffel Weißweinessig vermischt wird. Anschließend ist es wichtig, die Gurke gründlich auszudrücken, um jegliche überschüssige Flüssigkeit zu entfernen. Dies kann man am besten mit einem Geschirrtuch erledigen. Als nächstes wird der Joghurt zusammen mit der fein zerkleinerten Knoblauchzehe, zwei Esslöffeln Weißweinessig und zwei Esslöffeln Olivenöl vermischt.

Nachdem die Gurke ausreichend entwässert wurde, wird sie zur Joghurtmischung gegeben. Das ganze wird sorgfältig verrührt, bis sie eine samtige Konsistenz erreicht. Schließlich wird die Mischung nach Geschmack mit Pfeffer und Salz gewürzt und durch die Zugabe von fein gehacktem Dill verfeinert.

Nachtisch von Dirk Götz

Der Nachtisch sollte etwas Einfaches werden, aber dennoch zum Grillen passen. Daher war mein Vorschlag die gegrillte Ananas, Valeria schlug Schokobanane vor und zu beidem passt Vanilleeis super dazu. Also planten wir für jeden mit zwei Stückchen Ananas, einer halben Schokobanane und einer Kugel Eis.

Du brauchst:

Frische, reife Ananas

Bananen und Zartbitterschokolade

Vanilleeis

So geht`s:

Erst das obere und untere Ende von der Ananas abschneiden und die Schale abschneiden. Jetzt die Ananas vierteln und den Strunk entfernen. Nun in Scheiben oder Spalten von 2-3 cm Dicke schneiden. Diese dann grillen bis sie leicht gebräunt sind und Linien vom Grillrost zu sehen sind. Ist die Ananas nicht reif genug kann man auch mit etwas Rohrzucker für zusätzliche Süße sorgen, der karamellisiert zusätzlich beim Grillen. Eine andere Option ist, die Ananas mit etwas gutem Rum einzulegen, was ihr auch nochmal ein anderes Aroma gibt.

Für die Schokobananen einfach die Banane samt Schale einschneiden, etwa zwei Reihen von der Schokolade abbrechen und in den Einschnitt stecken. Anschließend auf den Grill legen, bis die Schokolade geschmolzen ist. Danach am besten mit einem scharfen Messer halbieren, so dass sie leichter aus der Schale gegessen werden kann.

Das Vanilleeis einfach portionieren und neben Ananas und Schokobanane anrichten.

Schlusswort von Christoph Breit

Abschließend bleibt zu sagen, dass jeder satt geworden ist und die Bewertungen durchweg positiv ausgefallen sind. Das Daniel-Bodky-Zitat „Azubis sind einfach die besseren Kollegen“ war des Öfteren zu hören. Aber am wortgewandtesten war unser Tobias Redel mit „Vielen, vielen Dank! Das Essen war sehr geil! Frisch gebackenes Brot und der Nachtisch vom Grill ist dabei „Next Level“. Das hat man beim Grillen selten.“

Abschließend bleibt zu sagen, dass jeder satt geworden ist und die Bewertungen durchweg positiv ausgefallen sind. Das Daniel-Bodky-Zitat „Azubis sind einfach die besseren Kollegen“ war des Öfteren zu hören. Aber am wortgewandtesten war unser Tobias Redel mit „Vielen, vielen Dank! Das Essen war sehr geil! Frisch gebackenes Brot und der Nachtisch vom Grill ist dabei „Next Level“. Das hat man beim Grillen selten.“

Es waren coole Erfahrungen, die man normalerweise so nicht hat und wir hatten beim Vor- und Nachbereiten jede Menge Spaß. Außerdem hoffen wir, dass wir bald auch einmal den Komfort haben werden, uns von den Kollegen bekochen zu lassen.

Anschließend waren wir beim Baumarkt und haben die Gasflasche für unseren Gasgrill auffüllen lassen. So war sichergestellt, dass uns nicht plötzlich während des Grillens das Gas ausgeht und die Leute hungrig bleiben müssen.

Anschließend waren wir beim Baumarkt und haben die Gasflasche für unseren Gasgrill auffüllen lassen. So war sichergestellt, dass uns nicht plötzlich während des Grillens das Gas ausgeht und die Leute hungrig bleiben müssen.

In der Zwischenzeit kannst Du die Salatgurken gründlich abwaschen und samt der Schale mithilfe eines Gemüsehobels in feine Scheiben schneiden. Diese knackige Ergänzung verleiht dem Salat eine erfrischende Textur und einen leichten Biss.

In der Zwischenzeit kannst Du die Salatgurken gründlich abwaschen und samt der Schale mithilfe eines Gemüsehobels in feine Scheiben schneiden. Diese knackige Ergänzung verleiht dem Salat eine erfrischende Textur und einen leichten Biss. In diesem ersten Teil ging es um das Grillgut und die Salate als Beilage. Im zweiten Teil kommen dann noch weitere Rezepte zu Broten, Dips und der Nachtisch dazu, denn wir wollten es uns natürlich richtig gut gehen lassen. Was auch schon das Abstimmungsergebnis gezeigt hat. 😉

In diesem ersten Teil ging es um das Grillgut und die Salate als Beilage. Im zweiten Teil kommen dann noch weitere Rezepte zu Broten, Dips und der Nachtisch dazu, denn wir wollten es uns natürlich richtig gut gehen lassen. Was auch schon das Abstimmungsergebnis gezeigt hat. 😉