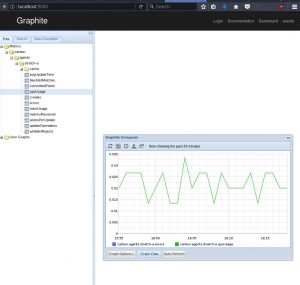

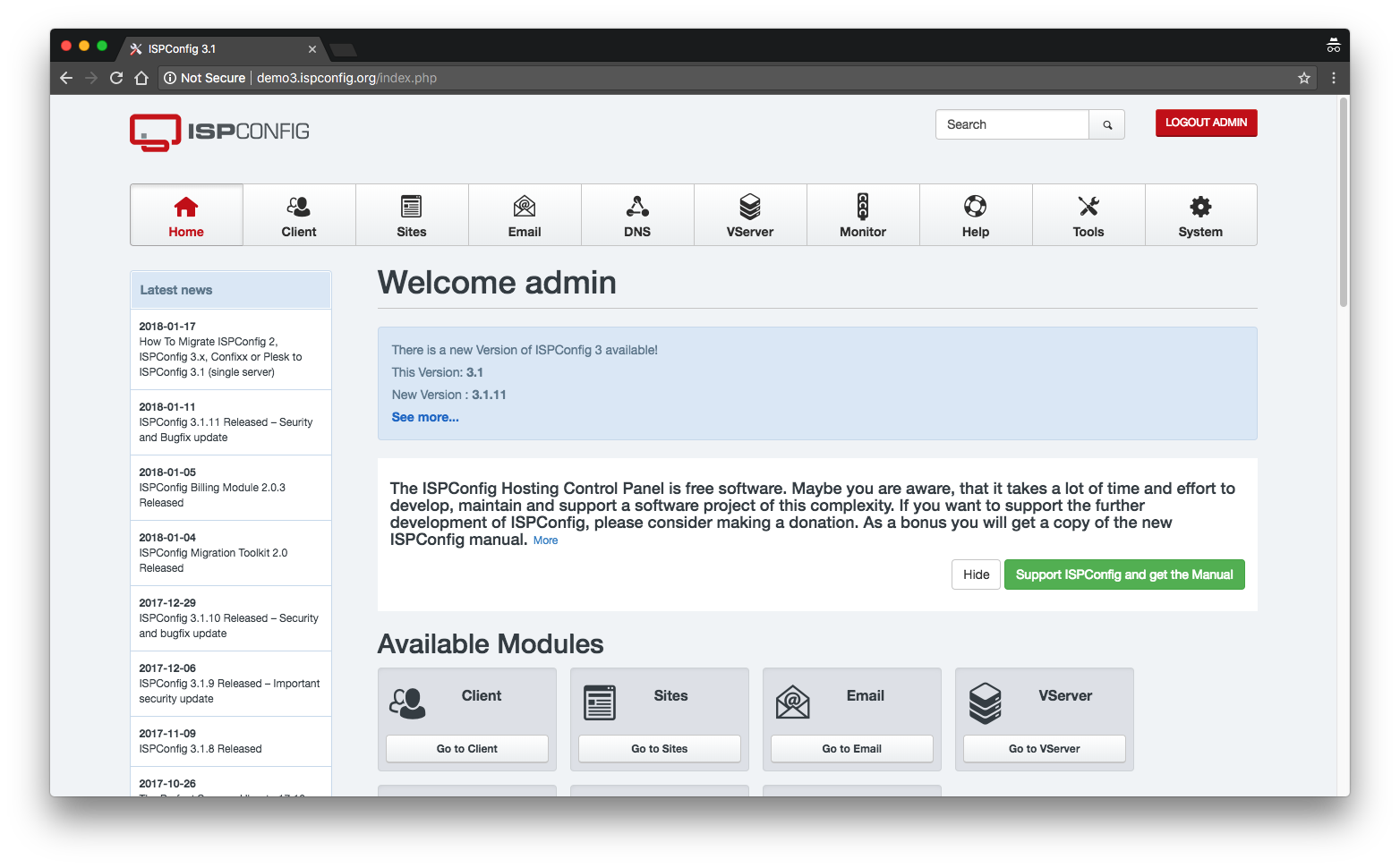

Für Administratoren die sich nicht viel mit der CLI (Command Line Interface) beschäftigen wollen, gibt es die Administrationssoftware ISPConfig 3, eine Open-Source Software für Linux.

Dieses Tool ermöglicht eine umfangreiche Verwaltung von einem oder mehreren Server durch ein webbasiertes Front-End, welches jedoch vorher über die CLI installiert wird. 🙂

Die Installation kann sowohl auf physischen sowie auf virtuellen Servern erfolgen und unterstützt werden die Distributionen:

- Debian 5 – 9 (empfohlen)

- Ubuntu 8.10 – 17.10 (empfohlen)

- CentOS 5.2 – 7

- Fedora 10 und 12 – 20

- OpenSUSE 11.1 – 13.1

Die Zugriffsebenen teilen sich auf den Administrator, Wiederverkäufer und Kunden ein. Kunden und Wiederverkäufer können auf der Weboberfläche einfach über Kunden > Kunde/Reseller hinzufügen, hinzugefügt werden.

Automatisierte Installation der Konfigurationsoberfläche und der jeweiligen Server-Dienste wie E-Mailserver, Webserver, DNSserver, Dateiserver, Datenbankserver, vServer und XMPP Server durch einen Script, machen es dem unerfahrenen Linux Benutzer um einiges einfacher. Über die Oberfläche lassen sich Webseiten mit letsencrypt wie aus Magie kostenlos mit gültigen Zertifikaten signieren.

Unterstützte werden die Daemons:

- HTTP: Apache2 und nginx

- SMTP: Postfix

- POP3/IMAP: Courier und Dovecot (1.2.x)

- FTP: PureFTPd

- DNS: BIND und MyDNS

- Datenbank: MySQL

- Statistiken: Webalizer und AWStats

- Virtualization: OpenVZ

Quick-Guide für Ubuntu und Debian

Bitte nur auf einem frischen Server ohne jegliche Vorinstallationen ausführen um Probleme zu vermeiden.

Vorbereitung

apt-get update && apt-get -y upgrade apt-get install -y unzip cd /tmp wget --no-check-certificate -O installer.tgz "https://github.com/servisys/ispconfig_setup/tarball/master" tar zxvf installer.tgz

Installation

cd *ispconfig* bash install.sh

Die Installation erfolgt dann durch Beantwortungen von Fragen im auswählbaren Experten- oder Standartmodus, dazu gehört auch die Wahl zwischen der Einrichtung von einem Master- oder Slaveserver (Automatisiert nur im Expertenmodus und nur unter Debian).

Shall this server join an existing ISPConfig multiserver setup (y,n) [n]: y

Beispielsweise wird als erstes auf Server1 eine Masterinstallation durchgeführt, danach muss auf Server2 bei einer Slaveinstallation der Hostname und die dazugehörigen Datenbankinformationen des Server1, nach der bejahten Frage ob bereits ein Multiserver setup existiert, eingetragen werden. Der Rest wird dann im Hintergrund automatisch erledigt.

Weitere Informationen und Features zum ISPConfig 3: klick mich

Demo ISPConfig 3: klick mich

Nach der Installation erspart man sich als Admin einiges an Tipparbeit und vermeidet dadurch fatale Konfigurationsfehler.

Zum Ausklang des Jahres 2017 gibt es nochmals einen Post zum Thema Puppet und Icinga. Es geht heute um das Ziel, einen Icinga-Server inklusive Icinga Web 2 mittels Puppet zu managen. Die Icinga IDO sowie eine Datenbank zur Authentifizierung am Icinga Web 2 sind beide als MySQL-Datenbanken realisiert. Kommandos von Icinga Web 2 werden zum Icinga-Core via Icinga-2-API übertragen.

Zum Ausklang des Jahres 2017 gibt es nochmals einen Post zum Thema Puppet und Icinga. Es geht heute um das Ziel, einen Icinga-Server inklusive Icinga Web 2 mittels Puppet zu managen. Die Icinga IDO sowie eine Datenbank zur Authentifizierung am Icinga Web 2 sind beide als MySQL-Datenbanken realisiert. Kommandos von Icinga Web 2 werden zum Icinga-Core via Icinga-2-API übertragen.

, sodass Sie als User sich damit nicht beschäftigen müssen.

, sodass Sie als User sich damit nicht beschäftigen müssen.