Pünktlich zu Weihnachten beschenken wir unsere NWS Kunden mit einer kleinen, aber feinen Neuerung im Kundenportal von nws.netways.de. Dort könnt ihr ab sofort mit den ersten OpenStack Objekten/Ressourcen aus dem NWS Webinterface interagieren! VMs, Floating IPs und Keys lassen sich jetzt direkt im Kundenportal übersichtlich, schnell und einfach erstellen, anzeigen oder löschen. Weitere OpenStack Objekte/Ressourcen werden konsequenterweise im neuen Jahr folgen.

Für unsere Kunden hat das den Vorteil, dass sie über die vereinfachte Maske unkompliziert neue virtuelle Maschinen anlegen können, ohne sich – wie bisher – durch ein detaillierteres Interface zu klicken. Der bisherige Zugriff über die Openstack API sowie über cloud.netways.de, bleibt aber natürlich für unsere IT-Expert:innen weiterhin bestehen.

Welche Vorteile bringt die neue OpenStack Integration?

Zusätzlich zur einfacheren Benutzerführung wurde zudem das neue Interface deutlich schneller und asynchron umgebaut. Aufgaben wie das Erstellen von VMs oder Kubernetes Clustern, die in der Regel mehrere Sekunden bis Minuten benötigen, werden ab heute im Hintergrund verarbeitet. Einsehen könnt ihr diese Aufgaben über das Zahnrad neben dem Nutzerprofil. Alle laufenden Aufgaben lassen sich dort jederzeit abrufen.

Somit lassen sich alle VMs einfach und übersichtlich steuern und die Prozesse laufen im Hintergrund ab, ohne dass ihr sie weiter im Auge behalten müsst. Das bedeutet, dass ab jetzt zusätzlich andere Aufgaben hinzugefügt werden können!

Was genau ist also jetzt neu?

Ebenso neu im OpenStack Interface sind die Punkte Servers, Key Pairs und Floating IPs:

- Servers – Dies ist der wichtigste Abschnitt, unter dem die Erstellung der VMs stattfindet. Hier findet man zudem eine schnelle Übersicht über den Zustand aller aktiven Produkte.

- Key Pairs – die SSH-Schlüssel lassen sich hier einfach einsehen und verwalten

- Floating IPs – Server IP-Adressen lassen sich hier einsehen und löschen

Wie starte ich schnell und einfach diese VMs?

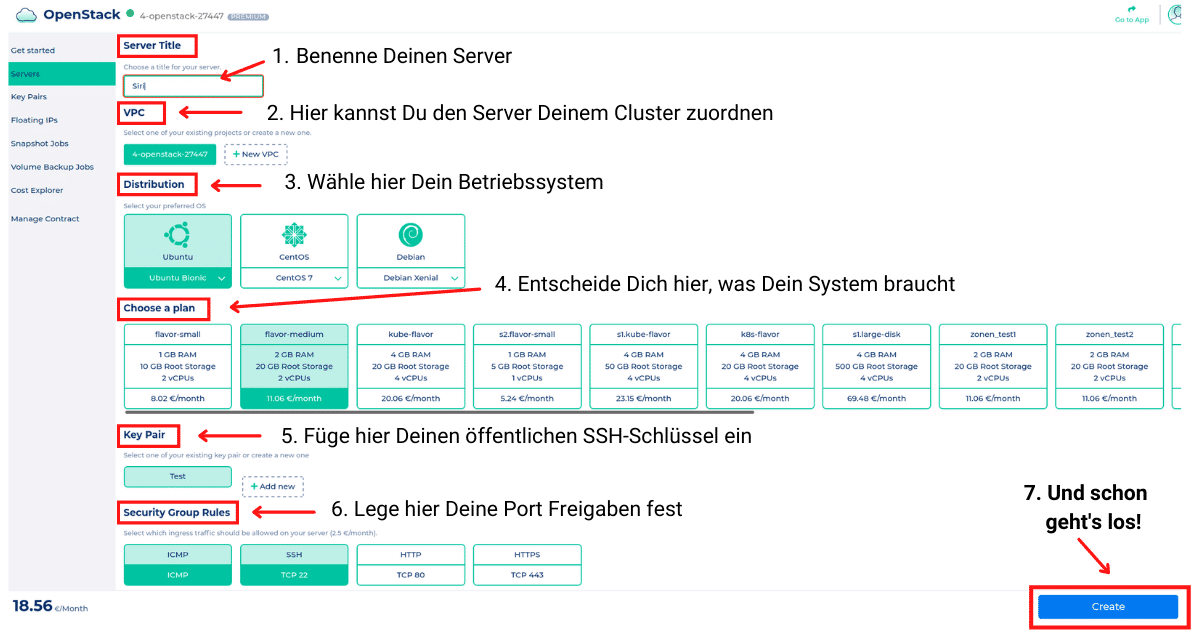

Bei der Erstellung eines neuen Servers hat man die Möglichkeit, den Server seinem Cluster zuzuordnen, ein Betriebssystem zu wählen, die benötigten Server Ressourcen festzulegen, einen SSH Schlüssel zu hinterlegen und die Port Freigabe festzulegen.

Im Interfacesieht sieht das dann wie folgt aus, wenn Du die einzelnen Optionen auswählst:

Und nicht vergessen einen Haken bei Terms of Service und Privacy Terms zu setzen! 🙂

Bearbeiten, während Du arbeitest!

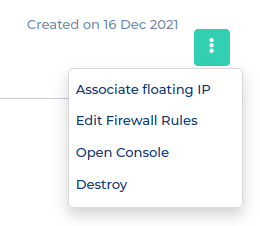

Sobald alles ausgewählt ist und Du auf Create geklickt hast, geht’s direkt los. Du musst nicht auf die komplette Erstellung des Servers warten, sondern kannst direkt eine IP Adresse vergeben, die Ports nochmal abändern oder den Server auch direkt wieder löschen.

Parallel dazu kannst Du die einzelnen Aufgaben über das Zahnrad neben dem Login einsehen, während diese im Hintergrund ablaufen und wirst sofort benachrichtigt, sobald eine abgeschlossen ist.

In der Servers Übersicht, können die laufenden Server mit ihren eingestellten Ressourcen eingesehen werden. Ein Teil der Verwaltungsfunktionen sind direkt in der NWS Übersicht abrufbar. Funktionen die aktuell verfügbar sind:

- Release/Associate Floating IP – Einsehen/Löschen

- Edit Firewall Rules – Einstellungen Port Freigabe

- Open Console – Direkter Zugriff auf die Server Console

- Destroy – Löschen des Servers

Bei Problemen mit der Erstellung oder Verwaltung der VMs stehen unsere MyEngineers jederzeit gerne mit Rat und Tat zur Seite. Wir sind zum Beispiel über das Kontaktformular zu erreichen.

Ein frohes Fest und schöne Feiertage wünscht Euch NETWAYS Web Services!

Früher gab es keine Möglichkeit auf einem physischen Server Ressourcengrenzen für eine Anwendung zu setzen. Beanspruchte eine App viele Ressourcen, blieb für die anderen entsprechend wenig zur Verfügung. Dieses Problem wurde durch die Virtualisierung gelöst. Nun konnte die CPU von einem physikalischen Server auf mehrere Virtuelle Maschinen aufgeteilt werden. Jede VM bekommt hierbei feste Ressourcengrenzen zugeteilt und somit können mehrere Apps nebeneinander auf einem Server laufen, ohne sich gegenseitig die notwendigen Ressourcen streitig zu machen. Durch die Virtualisierung war nun auch die Möglichkeit der Skalierbarkeit gegeben. Bei Bedarf lassen sich die Ressourcen einer VM leicht erhöhen und später genauso wieder herunterdrehen. So lässt sich ein physischer Server wesentlich kosteneffizienter betreiben.

Früher gab es keine Möglichkeit auf einem physischen Server Ressourcengrenzen für eine Anwendung zu setzen. Beanspruchte eine App viele Ressourcen, blieb für die anderen entsprechend wenig zur Verfügung. Dieses Problem wurde durch die Virtualisierung gelöst. Nun konnte die CPU von einem physikalischen Server auf mehrere Virtuelle Maschinen aufgeteilt werden. Jede VM bekommt hierbei feste Ressourcengrenzen zugeteilt und somit können mehrere Apps nebeneinander auf einem Server laufen, ohne sich gegenseitig die notwendigen Ressourcen streitig zu machen. Durch die Virtualisierung war nun auch die Möglichkeit der Skalierbarkeit gegeben. Bei Bedarf lassen sich die Ressourcen einer VM leicht erhöhen und später genauso wieder herunterdrehen. So lässt sich ein physischer Server wesentlich kosteneffizienter betreiben. An dieser Stelle kommt nun Kubernetes ins Spiel. Denn irgendjemand muss bei den ganzen Microservices ja den Überblick und das Steuer in der Hand behalten. Das Kubernetes Projekt wurde 2014 von Google als OpenSource-Projekt veröffentlicht. Der Name kommt aus dem Griechischen und bedeutet so viel wie Steuermann/ Pilot. In Kurzform wird es auch oft als „k8s“ bezeichnet.

An dieser Stelle kommt nun Kubernetes ins Spiel. Denn irgendjemand muss bei den ganzen Microservices ja den Überblick und das Steuer in der Hand behalten. Das Kubernetes Projekt wurde 2014 von Google als OpenSource-Projekt veröffentlicht. Der Name kommt aus dem Griechischen und bedeutet so viel wie Steuermann/ Pilot. In Kurzform wird es auch oft als „k8s“ bezeichnet. Die größte Herausforderung bei Kubernetes liegt in der Komplexität des eigentlichen Erstellens, Betriebs und Instandhaltens des Kubernetes Clusters. Und hier kommt die gute Nachricht für Dich: diese Aufgaben liegen komplett bei uns. Wir sorgen im Hintergrund permanent für Updates, Backups und eine stabile zugrunde liegende Infrastruktur. Diese besteht auch hier aus unserer OpenStack Umgebung, mittels derer alle notwendigen VMs, Loadbalancer etc. gestartet werden. Unsere Kunden können also sämtliche Annehmlichkeiten von Kubernetes nutzen, ohne sich um den Aufbau des nötigen Fachwissens zum Betrieb eines K8s-Clusters kümmern zu müssen.

Die größte Herausforderung bei Kubernetes liegt in der Komplexität des eigentlichen Erstellens, Betriebs und Instandhaltens des Kubernetes Clusters. Und hier kommt die gute Nachricht für Dich: diese Aufgaben liegen komplett bei uns. Wir sorgen im Hintergrund permanent für Updates, Backups und eine stabile zugrunde liegende Infrastruktur. Diese besteht auch hier aus unserer OpenStack Umgebung, mittels derer alle notwendigen VMs, Loadbalancer etc. gestartet werden. Unsere Kunden können also sämtliche Annehmlichkeiten von Kubernetes nutzen, ohne sich um den Aufbau des nötigen Fachwissens zum Betrieb eines K8s-Clusters kümmern zu müssen.

So lässt sich das OpenStack Projekt bequem und übersichtlich über unser Dashboard zusammenstellen und einrichten. Der Punkt der Übersichtlichkeit führt mich auch gleich zu einem weiteren wichtigen Vorteil unseres OpenStack Angebots: Bezüglich der Kosten können wir ein maximales Maß an Transparenz bereitstellen. Es gibt keine undurchsichtigen Pauschalen und Gesamtpakete. Alle verwendeten Ressourcen werden stundengenau abgerechnet. Über unseren Cost Explorer siehst Du die für den Monat bereits entstanden Kosten und bekommst anhand der aktuell genutzten Ressourcen auch gleich eine Hochrechnung über die voraussichtliche Summe am Monatsende. Man hat die Kosten also zu jeder Zeit im Blick und kann im Bedarfsfall sofort reagieren. Das liegt auch daran, dass es keinerlei Vertragslaufzeiten gibt. Wird eine VM nicht mehr benötigt, kann man diese umgehend runterfahren. Am Monatsende zahlst Du dann nur den Betrag, der bis zu der Abschaltung entstanden ist. Das gibt Dir absolute Flexibilität in beide Richtungen – Du kannst schnell wachsen und, wenn nötig, Dein Setup auch direkt verkleinern.

So lässt sich das OpenStack Projekt bequem und übersichtlich über unser Dashboard zusammenstellen und einrichten. Der Punkt der Übersichtlichkeit führt mich auch gleich zu einem weiteren wichtigen Vorteil unseres OpenStack Angebots: Bezüglich der Kosten können wir ein maximales Maß an Transparenz bereitstellen. Es gibt keine undurchsichtigen Pauschalen und Gesamtpakete. Alle verwendeten Ressourcen werden stundengenau abgerechnet. Über unseren Cost Explorer siehst Du die für den Monat bereits entstanden Kosten und bekommst anhand der aktuell genutzten Ressourcen auch gleich eine Hochrechnung über die voraussichtliche Summe am Monatsende. Man hat die Kosten also zu jeder Zeit im Blick und kann im Bedarfsfall sofort reagieren. Das liegt auch daran, dass es keinerlei Vertragslaufzeiten gibt. Wird eine VM nicht mehr benötigt, kann man diese umgehend runterfahren. Am Monatsende zahlst Du dann nur den Betrag, der bis zu der Abschaltung entstanden ist. Das gibt Dir absolute Flexibilität in beide Richtungen – Du kannst schnell wachsen und, wenn nötig, Dein Setup auch direkt verkleinern.