Da ich vor kurzem für einen unserer namhaften Kunden ein GitLab Setup aufsetzten durfte und dieser sich nun auch Automatische Checkouts seiner Live Branches auf seinen Produktiv Systemen wünschte, habe ich mich dazu entschlossen euch ein bisschen an der Einrichtung dieser Mechaniken teilhaben zu lassen, natürlich nicht im vollem Umfang des Projektes für unseren Kunden, das eine oder andere habe ich für diesen Artikel verständlicherweise leicht abwandeln müssen, das hier gezeigte funktioniert trotzdem, ich habe es selber ausprobiert.

Dann legen wir mal los…

In einem klassischen Git Setup werden die Hooks direkt im Repository im Unterordner hooks abgelegt, hier mal ein Beispiel wie das aussehen kann…

$ MyAwesomeProject/hooks $ ll

-rwxrwxr-x 1 enzo enzo 452 Jun 28 11:46 applypatch-msg.sample*

-rwxrwxr-x 1 enzo enzo 896 Jun 28 11:46 commit-msg.sample*

-rwxrwxr-x 1 enzo enzo 189 Jun 28 11:46 post-update.sample*

-rwxrwxr-x 1 enzo enzo 398 Jun 28 11:46 pre-applypatch.sample*

-rwxrwxr-x 1 enzo enzo 1642 Jun 28 11:46 pre-commit.sample*

-rwxrwxr-x 1 enzo enzo 1239 Jun 28 11:46 prepare-commit-msg.sample*

-rwxrwxr-x 1 enzo enzo 1352 Jun 28 11:46 pre-push.sample*

-rwxrwxr-x 1 enzo enzo 4898 Jun 28 11:46 pre-rebase.sample*

-rwxrwxr-x 1 enzo enzo 3611 Jun 28 11:46 update.sample*

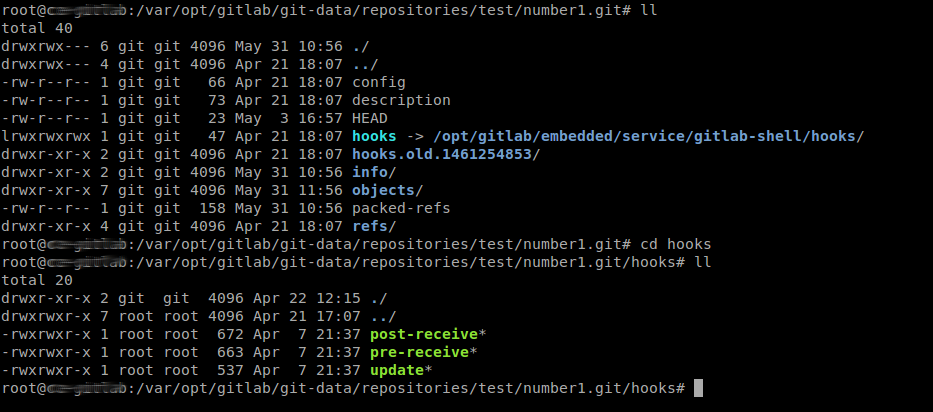

GitLab geht hier allerdings einen anderen Weg, da dieses das hooks Verzeichnis durch einen Symbolischen Link auf System eigene Hooks umlenkt (wie hier Beispielhaft zu sehen ist)…

…nun sollte man hier auch besser die Finger heraus lassen, da GitLab dieses Verzeichnis für allerlei anderen Mechaniken benötigt, der Weg über die Webhooks ist meiner Meinung nach aber auch flexibler (allein schon wegen der einfachen Anbindung an Web Dienste wie GitHub, Bitbucket, Heroku, etc.).

Nun direkt zum spaßigen Teil, im GitLab benötigen wir einen neuen User ohne irgendwelche besonderen Rechte incl. SSH Public Key, fangen wir mit dem Key selbst an, da der Checkout User keinen besonderen Rechte benötigt außer einen Pull/Fetch zu tätigen, reicht es uns den Key also entsprechend Unprivilegiert zu preparieren (bei der Passwortabfrage bitte nichts angeben, einfach mit Enter bestätigen)…

$ ssh-keygen -t rsa -b 2048 -O clear -O no-agent-forwarding -O no-port-forwarding -O no-pty -O no-user-rc -O no-x11-forwarding -f gitlab.key

Generating public/private rsa key pair.

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in gitlab.key.

Your public key has been saved in gitlab.key.pub.

The key fingerprint is:

4b:f3:ae:60:d4:5d:5e:02:75:64:4c:7f:ce:09:ec:8a enzo@ebony

The key's randomart image is:

+--[ RSA 2048]----+

| ...+= |

| ..o.. |

| oo. o|

| . . o.o.oo|

| . S . .. .o|

| . . +. . |

| o .E.. |

| . . . |

| ... |

+-----------------+

$ ll

insgesamt 8

-rw------- 1 enzo enzo 1675 Jun 28 11:52 gitlab.key

-rw-r--r-- 1 enzo enzo 392 Jun 28 11:52 gitlab.key.pub

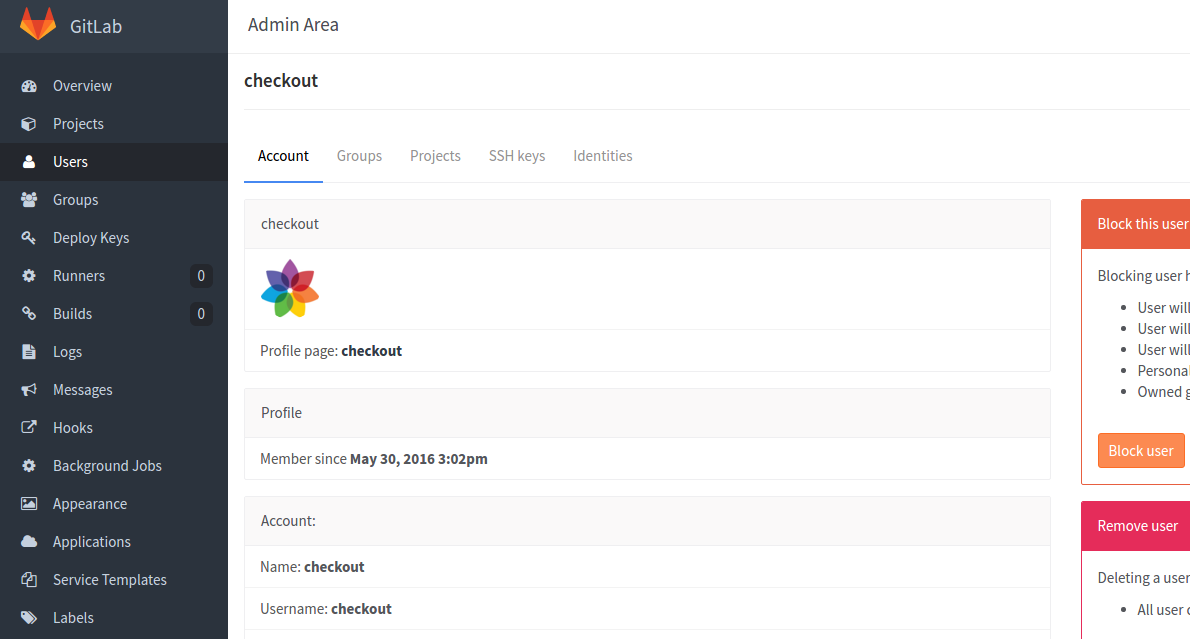

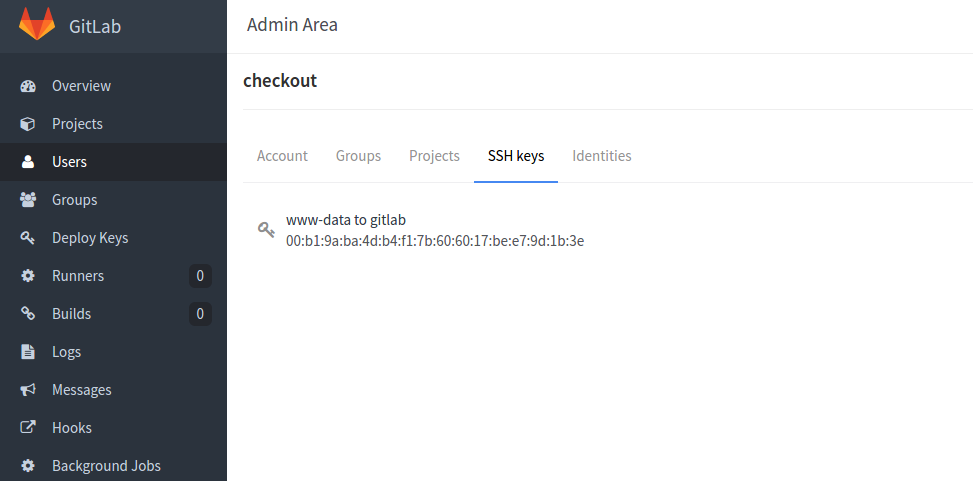

…nun benötigen wir lediglich noch einen User im GitLab, das sollte keine große Herausforderung darstellen, bitte stellt auch sicher das ihr den SSH PublicKey in unserem Beispiel gitlab.key.pub dem User, lasst ihn uns hier der Einfachheit halber checkout nennen zuweist, da die Webhooks mit den Berechtigungen des Standard Apache User www-data läuft (das ist zumindest unter Debian/Ubuntu der Fall, unter Redhat Systemen heißt dieser wwwrun) solltet ihr dem Key als Identifier so etwas wie www-data to gitlab oder ähnliches benennen, damit ihr später ganz einfach den Überblick behalten könnt…

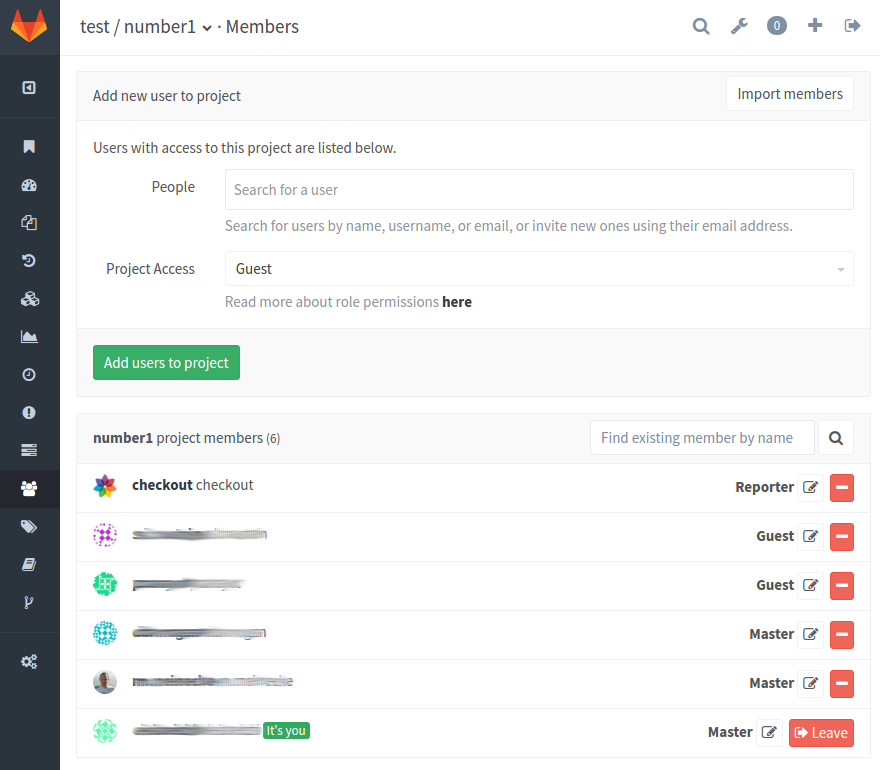

…nun müssen wir unserem User checkout lediglich noch in unser Projekt aufnehmen, die Rechte eines Reporter sollten dafür ausreichend sein um Fetch/Pull oder auch Clone zu können, mehr benötigen wir an dieser Stelle nicht…

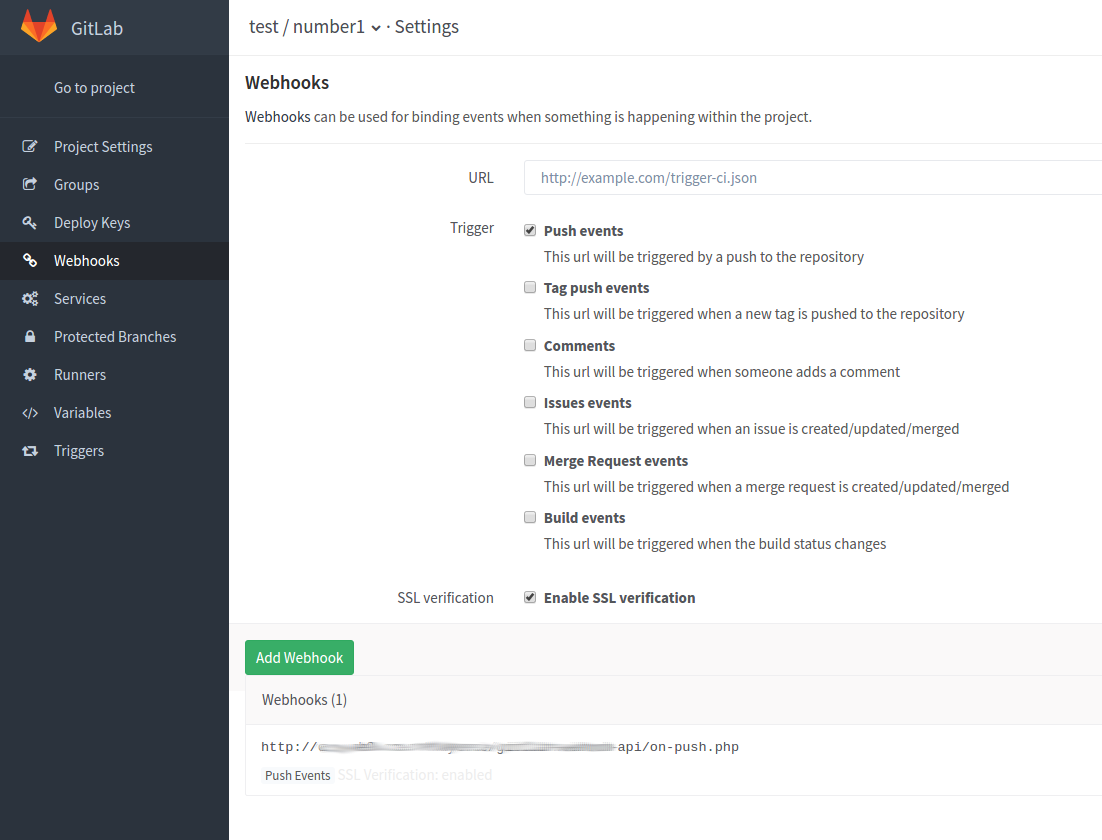

…somit sind wir auf schon fast fertig, zumindest was das GitLab Setup selbst betrifft, nun müssen wir lediglich noch die URL unseres Webhook konfigurieren und schon können wir uns dem Hook selber widmen…

So nun geht es an den Server der unseren Webhook ausführen soll, ihr benötigt lediglich einen simplen Apache/NginX vHost mit Standard Rechten, man kann selbstverständlich auch ein komplizierteres Deployment bauen aber darum geht es in diesem Artikel nicht (ich nutzte hier den Apache2 mit PHP5, da dieser bereits auf dem Kunden System vorhanden wahr und zusätzliche Scriptsprachen installieren ist meist schlechte Praxis sowie auch unnötiger Aufwand).

Ich habe mich hier für den Standard Pfad des Apache Setups entschieden da der Standard vHost bereits auf diesen zeigt und dieser auch nur aus dem internen Netz bedienbar ist, somit ist sichergestellt das Niemand von außerhalb Unfug treiben kann.

Dort habe ich im DocumentRoot des Apache ein Verzeichnis api erstellt, der volle Pfad lautet hier /var/www/html/api, dort habe ich mein Webhook mit Namen on-push.php abgelegt, dieser hat nun folgenden Inhalt…

object_kind == 'push' ) {

if( $obj->ref == 'refs/heads/'.BRANCH ) {

$allowed = false;

foreach( $USERS as $user ) {

msg( "permission test ( ".$obj->user_name ." == ". $user." ) ..." );

if( preg_match( "/$user/i", $obj->user_name ) ) {

msg( $user . " allowed to do updates on refs/heads/".BRANCH." branch" );

$allowed = true;

break;

}

}

if( $allowed ) {

if( $obj->before != "0000000000000000000000000000000000000000" ) {

msg( "changing directory to ".PROJECTROOT );

chdir( PROJECTROOT );

msg( "executing: ". COMMAND );

$fh = popen( COMMAND." 2>&1", "r" );

$result = fread( $fh );

while( !feof( $fh ) ) {

msg( rtrim(fgets( $fh, 4096 )) );

}

pclose( $fh );

} else {

msg( "it's a empty repository, we'll do nothing at this point" );

}

} else {

msg( "permission denied for ". $obj->user_name );

}

} else {

msg( "everybody can push to ". $obj->ref.", but we'll do nothing, please check your project settings" );

}

} else {

msg( "[ ". $obj->object_kind ." ] event handler not yet implemented" );

}

} else {

msg( strtoupper($_SERVER['REQUEST_METHOD'])." from [ ".$_SERVER['REMOTE_ADDR'] ." ] is not allowed, please check your server settings" );

return_status( ERR );

}

} catch( Exception $e ) {

msg( "======= EXCEPTION BEGIN ========" );

msg( $e->getMessage() );

msg( "======= EXCEPTION END ==========" );

return_status( ERR );

}

return_status( OK );

// ================================ FUNCTIONS ===========================================

function return_status( $status = ERR ) { header( $status ); }

function getRequestBody() { return json_decode( file_get_contents('php://input') ); }

function msg( $message ) { if( $message != null ) file_put_contents( LOGFILE, $message."\n", FILE_APPEND ); }

?>

..damit das nun funktionieren kann, müssen wir nun noch das Projekt Klonen und die SSH Settings anlegen, fangen wir daher direkt mit den SSH Settings an…

# (beginne mit Root Login)

su - -s /bin/bash www-data

mkdir -p .ssh && chmod 0600 .ssh

exit

cp gitlab.key /var/www/.ssh/ && chown www-data. /var/www/.ssh/gitlab.key && chmod 0400 /var/www/.ssh/gitlab.key

su - -s /bin/bash www-data

vi .ssh/config

…die .ssh/config sieht dabei wie folgt aus…

Host gitlab.example.org

UserKnownHostsFile /dev/null

StrictHostKeyChecking no

IdentityFile ~/.ssh/gitlab.key

User git

LogLevel VERBOSE

…speichert nun das ganze und Klont eurer Projekt nach /var/www/project1/htdocs …

# (beginne mit Root Login)

su - -s /bin/bash www-data

cd /var/www/project1

git clone git@gitlab.example.org:test/number1.git htdocs

…wenn ihr nun Lokal mit eurer Arbeitskopie arbeitet und an dem Punkt seit das ihr alles fertig zuhaben scheint und dann einen Push in euren staging Branch macht, wird GitLab jedesmal den Webhook on-push.php Aufrufen und auf dem Projekt/Web -Server einen Fetch/Pull ausführen lassen, um das Projekt auf den selben Stand wie eure Arbeitskopie zu bringen.

Zugegeben der PHP Handler oben ist keinesfalls perfekt, ich bin auch kein guter PHP Programmierer, genau genommen eigentlich gar keiner ;). Der Hook für das Kunden Projekt umfasst zudem noch mehr Fähigkeiten und würde mit seine zu diesem Zeitpunt ca. 800 Zeilen diesen Artikel in jedem Fall sprengen, aber ich denke das der gezeigte Webhook oben bereits eine gute Ausgangsbasis darstellt, sodass ich euch hoffentlich dazu Animieren konnte, das ganze doch einmal selber nachzubauen.

Zum zweck des Debugging, loggt dieser zur Kontrolle nach /var/www/html/api/on-push.log , hier lohnt also ein Blick.

Noch ein kleiner Hinweis meinerseits, der eine oder andere von euch wird schnell feststellen, das GitLab selber im Admin Panel auch einen Menü Eintrag mit der Bezeichnung [Deploy Keys] bereitstellt, womit sich das oben gezeigte auch umsetzten lässt, aufgrund einiger bedenken bzgl. Sicherheit dieses allerdings nicht immer gewünscht ist, da alle Keys die dort hinterlegt werden automatisch, für allen Projekte (auch für zukünftige) direkt verwendet werden können.

Nützliche Links:

30 May – 3 June slipped into summer with a peek into a Puppet consulting project and tips for JavaScript testing and virtualisation.

30 May – 3 June slipped into summer with a peek into a Puppet consulting project and tips for JavaScript testing and virtualisation.