Last year's Open Source Monitoring Conference (OSMC) was a great experience. It was a pleasure to meet attendees from around the world and participate in interesting talks about the current and future state of the monitoring field. Personally, this was my first time...

NETWAYS Blog

Hier erfährst Du alles was uns bewegt. Technology, Hardware, das Leben bei NETWAYS, Events, Schulungen und vieles mehr.

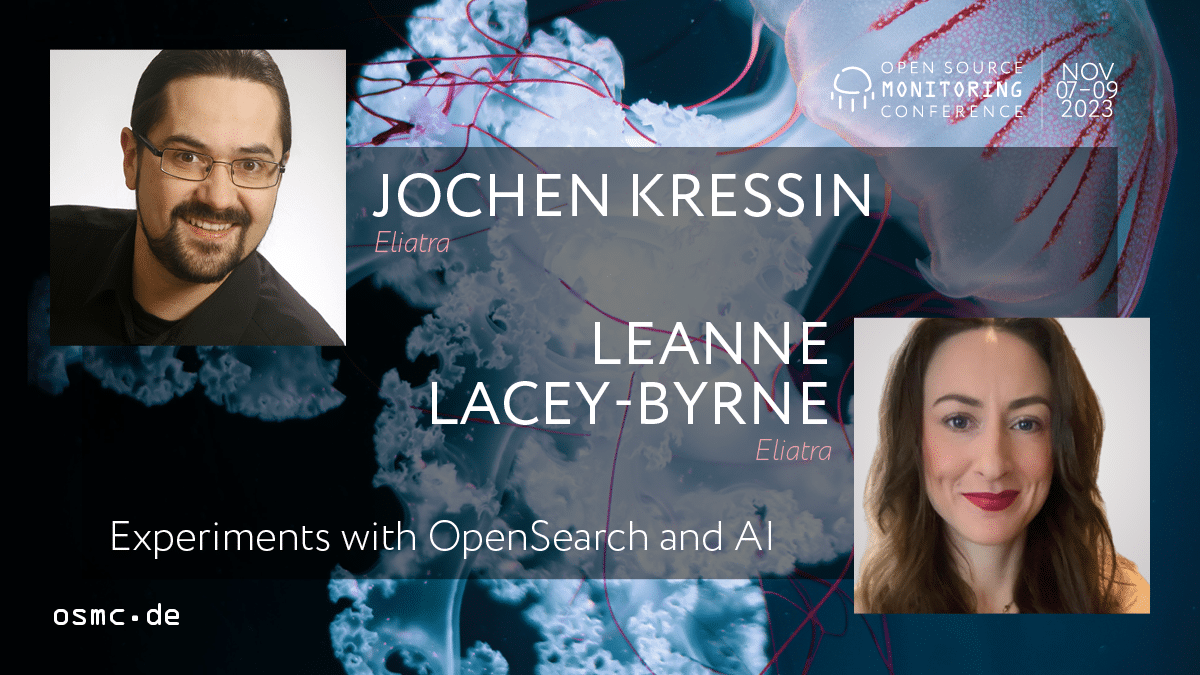

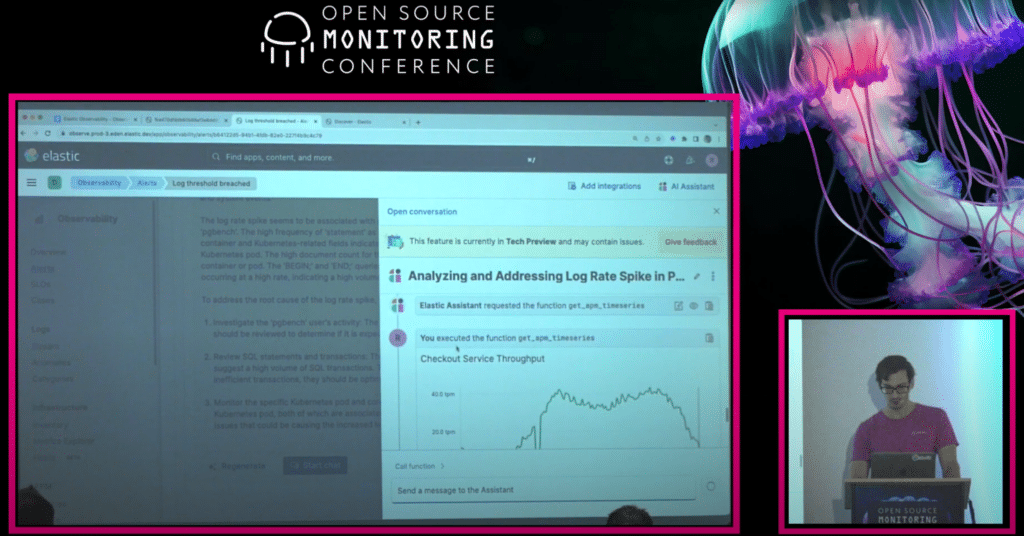

OSMC 2023 | Experiments with OpenSearch and AI

Last year's Open Source Monitoring Conference (OSMC) was a great experience. It was a pleasure to meet attendees from around the world and participate in interesting talks about the current and future state of the monitoring field. Personally, this was my first time...

OSMC 2023 | Experiments with OpenSearch and AI

Last year's Open Source Monitoring Conference (OSMC) was a great experience. It was a pleasure to meet attendees from around the world and participate in interesting talks about the current and future state of the monitoring field. Personally, this was my first time...

OSMC 2024 is Calling for Sponsors

What about positioning your brand in a focused environment of international IT monitoring professionals? Discover why OSMC is just the perfect spot for it. Meet your Target Audience Sponsoring the Open Source Monitoring Conference is a fantastic opportunity to...

DevOpsDays Berlin 2024 | The Schedule is Online!

We're excited to share that DevOpsDays Berlin is making a comeback this year! After a one-year break, the event will happen on May 7 & 8 in Berlin. And we've got some great news for you! The Program is All Set! Yes, you heard it right. The two-day program...

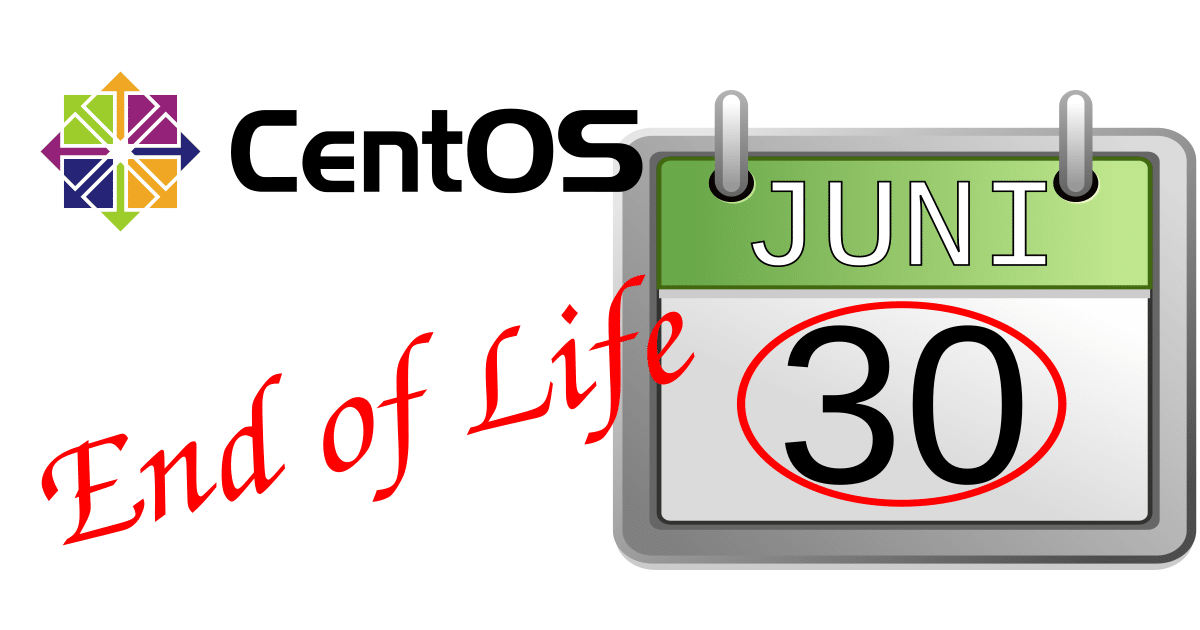

End of Life von CentOS Linux 7 – Was bedeutet das für mich?

Der ein oder andere Admin wird sich vermutlich schon lange den 30. Juni 2024 im Kalender vorgemerkt haben, denn dann ist für CentOS Linux 7 das "End of Life" erreicht. Aber auch Benutzer von Red Hat Enterprise Linux 7 sollten sich Gedanken machen, denn auch dieses...

Lösungen & Technology

End of Life von CentOS Linux 7 – Was bedeutet das für mich?

Der ein oder andere Admin wird sich vermutlich schon lange den 30. Juni 2024 im Kalender vorgemerkt haben, denn dann ist für CentOS Linux 7 das "End of Life" erreicht. Aber auch Benutzer von Red Hat Enterprise Linux 7 sollten sich Gedanken machen, denn auch dieses...

End of Life von CentOS Linux 7 – Was bedeutet das für mich?

Der ein oder andere Admin wird sich vermutlich schon lange den 30. Juni 2024 im Kalender vorgemerkt haben, denn dann ist für CentOS Linux 7 das "End of Life" erreicht. Aber auch Benutzer von Red Hat Enterprise Linux 7 sollten sich Gedanken machen, denn auch dieses...

End of Life von CentOS Linux 7 – Was bedeutet das für mich?

Der ein oder andere Admin wird sich vermutlich schon lange den 30. Juni 2024 im Kalender vorgemerkt haben, denn dann ist für CentOS Linux 7 das "End of Life" erreicht. Aber auch Benutzer von Red Hat Enterprise Linux 7 sollten sich Gedanken machen, denn auch dieses...

CVSS:Medium: Elastic Sicherheits-Updates gleich für drei Produkte

Gleich drei Sicherheits-Updates für drei verschiedene Produkte wurden von Elastic veröffentlicht. Alle drei haben den Schweregrad Medium. Jedoch ist es Ratsam die Updates durchzuführen. Folgend eine kurze Zusammenfassung je Produkt. Link: APM Server 8.12.1 Security...

NETWAYS GitHub Update Januar 2024

NETWAYS GitHub Update November 2023

Events & Trainings

OSCamp 2024 | Großen Dank an unsere Sponsoren!

Wir sagen Dankeschön! Die Vorbereitungen für das OSCamp für Kubernetes 2024 sind in vollem Gange, und während wir uns auf das kommende Event freuen, möchten wir die Gelegenheit nutzen, um unseren Gold-Sponsoren zu danken. Ihre großzügige Unterstützung macht diese...

OSCamp 2024 | Großen Dank an unsere Sponsoren!

Wir sagen Dankeschön! Die Vorbereitungen für das OSCamp für Kubernetes 2024 sind in vollem Gange, und während wir uns auf das kommende Event freuen, möchten wir die Gelegenheit nutzen, um unseren Gold-Sponsoren zu danken. Ihre großzügige Unterstützung macht diese...

OSCamp 2024 | Großen Dank an unsere Sponsoren!

Wir sagen Dankeschön! Die Vorbereitungen für das OSCamp für Kubernetes 2024 sind in vollem Gange, und während wir uns auf das kommende Event freuen, möchten wir die Gelegenheit nutzen, um unseren Gold-Sponsoren zu danken. Ihre großzügige Unterstützung macht diese...

OSMC 2024 is Calling – Save the Date!

Come, Join Us! The Open Source Monitoring Conference is back for its 18th edition! Be sure to mark your calendars for November 19 – 21 and join us in Nuremberg. At OSMC, we gather experts from all over the world to discuss everything there is to know about open source...

stackconf 2024 | Announcing our First Speakers

The Wait is Over! We’re super excited to finally announce our first confirmed speakers for stackconf 2024. It’s a diverse group of international experts who specialize in cloud-native infrastructure solutions. Have a look and see which topics interest you the most....

Setze Deine Reise fort mit unseren Monitoring und Automation Trainings

In der sich ständig wandelnden Welt der IT-Landschaft sind Monitoring- und Automation-Technologien heute unerlässlich. Umso wichtiger ist es, sein Wissen und seine Fähigkeiten regelmäßig zu updaten. Hier präsentieren wir Dir eine Auswahl unserer Trainings, die Dich...

Web Services

Ceph Backfilling Crash: Datenintegrität manuell wiederherstellen

Seit vielen Jahren haben wir Ceph im Einsatz. Unser erstes produktives Cluster begleitet uns seit 2015. Auch wenn die ersten Major-Updates des Clusters holprig verliefen ist die nötige Pflege des Clusters mit jedem Release von Ceph geringer geworden. Abgesehen vom...

Ceph Backfilling Crash: Datenintegrität manuell wiederherstellen

Seit vielen Jahren haben wir Ceph im Einsatz. Unser erstes produktives Cluster begleitet uns seit 2015. Auch wenn die ersten Major-Updates des Clusters holprig verliefen ist die nötige Pflege des Clusters mit jedem Release von Ceph geringer geworden. Abgesehen vom...

Ceph Backfilling Crash: Datenintegrität manuell wiederherstellen

Seit vielen Jahren haben wir Ceph im Einsatz. Unser erstes produktives Cluster begleitet uns seit 2015. Auch wenn die ersten Major-Updates des Clusters holprig verliefen ist die nötige Pflege des Clusters mit jedem Release von Ceph geringer geworden. Abgesehen vom...

How I met your C2 : Basic Operational Security for Defense and Offense

Throughout this blogpost I want to share some awareness on search engines and current trends of fingerprinting. Some parts have tags for defense and offense. In the following Black Hats are considered evil and destructive, whereas Red Teams simulate Black Hats,...

Cloud Services and NWS-ID – It’s a match!

We're starting the new year with a new integration for you! As announced last year, the integration of further products with NWS-ID will continue in 2023! From now on the NWS Cloud Services are integrated with NWS-ID. What are the advantages of integrating our Cloud...

Was NWS Docs ist und wozu es dient

Vor zwei Wochen haben wir unser neues NWS ID realeasd und vorgestellt - heute möchten wir Dir noch etwas neues vorstellen: das NWS Docs. Es soll Dir dabei helfen, bei Fragen rund um Dein Costumer Interface oder sämtlichen Anwendungen, den richtigen Lösungsweg und...

Unternehmen

OSMC 2023 | Will ChatGPT Take Over My Job?

One of the talks at OSMC 2023 was "Will ChatGPT take over my job?" by Philipp Krenn. It explored the changing role of artificial intelligence in our lives, raising important questions about its use in software development. The Rise of AI in Software...

OSMC 2023 | Will ChatGPT Take Over My Job?

One of the talks at OSMC 2023 was "Will ChatGPT take over my job?" by Philipp Krenn. It explored the changing role of artificial intelligence in our lives, raising important questions about its use in software development. The Rise of AI in Software...

OSMC 2023 | Will ChatGPT Take Over My Job?

One of the talks at OSMC 2023 was "Will ChatGPT take over my job?" by Philipp Krenn. It explored the changing role of artificial intelligence in our lives, raising important questions about its use in software development. The Rise of AI in Software...

Monthly Snap Januar 2024

Hallo zusammen! Der erste Monat des Jahres war sehr produktiv bei uns, zumindest wenn man es anhand der Qualität der Blog-Posts bewertet! Schaut Euch unsere Höhepunkte noch mal an, vielleicht habt Ihr ja auch den ein oder anderen Post verpasst. stackconf...

NETWAYS stellt sich vor – Alvar Penning

Monitoring-Plugin check_system_basics: Erstes Release!

Für das Basis-Monitoring von Linux-Maschinen existieren viele Plugins im Monitoring-Universum. Grundlegende Änderungen an den zugrunde liegenden Schnittstellen sind eher selten, da viele Programme sehr langfristig darauf aufbauen. Deshalb erfüllen aktuelle Lösungen...

Blogroll

Da hast Du einiges zu lesen …

OSMC 2023 | Will ChatGPT Take Over My Job?

4 Gründe, warum Du Dir das OSCamp für Kubernetes nicht entgehen lassen solltest

Kubernetes ist mehr als nur eine Technologie – es ist eine Revolution in der Art und Weise, wie wir Anwendungen entwickeln, bereitstellen und skalieren. Wenn Du ebenso fasziniert von Kubernetes bist wie wir, dann ist das OSCamp 2024 genau das Richtige für Dich!

Hier sind einige Gründe, warum Du Dir dieses Event nicht entgehen lassen solltest:

Das OSCamp 2024 ist mehr als nur eine Konferenz – es ist eine einzigartige Gelegenheit, Deiner Leidenschaft für Kubernetes zu folgen und Dich weiterzuentwickeln. Sichere Dir jetzt Dein Ticket und sei am 18. April in Nürnberg mit dabei. Wir freuen uns auf Dich!

OSMC 2024 is Calling – Save the Date!

Come, Join Us!

The Open Source Monitoring Conference is back for its 18th edition!

Be sure to mark your calendars for November 19 – 21 and join us in Nuremberg.

At OSMC, we gather experts from all over the world to discuss everything there is to know about open source monitoring. It’s a unique opportunity to connect with like-minded individuals, share knowledge and explore the latest advances in the field.

Over the course of three action-packed days, attendees can immerse themselves in a variety of engaging activities. The conference kicks off with several hands-on workshops, providing participants with the chance to dive deep into practical application aspects and gain valuable insights from open source specialists.

Days two and three feature two technical tracks filled with enlightening case studies, best practices, and cutting-edge solutions. Whether you’re a seasoned professional or just starting out in the world of monitoring, there’s something for everyone at OSMC.

Exclusive Benefits for Sponsors!

Apart from the welcoming atmosphere, great vibes, and delicious food here in Nuremberg, with an OSMC sponsorship comes with tons of other benefits!

We offer our sponsors different packages to choose from: PLATINUM, GOLD, SILVER & BRONZE. If you want even more, our add-ons are just the thing for you. Check out our sponsorship prospectus to see what’s possible and what fits to your needs and budget.

Stay informed by subscribing to our mailing list and ensure you’re always among the first to receive the latest news.

stackconf 2024 | Announcing our First Speakers

The Wait is Over!

We’re super excited to finally announce our first confirmed speakers for stackconf 2024. It’s a diverse group of international experts who specialize in cloud-native infrastructure solutions. Have a look and see which topics interest you the most. There are more to come in the next few weeks. Stay tuned!

Spoiler Alert!

Here’s a small insight into our great line-up:

ALEX PSHE

ALEX PSHE

Step-by-step algorithm for building CI/CD as an automated quality control system

Alex’s presentation delves into CI/CD from a tester’s perspective, highlighting the importance of leveraging automated metrics for decision-making and adopting a fail-first approach in pipeline design. Throughout the talk, she explores different pipeline types and triggers for efficient testing, emphasizing key criteria for effectiveness. The role of Quality Gates and automated control systems in enforcing standards is also discussed, underscoring Alex’s focus on ensuring reliability and quality in software delivery.

ARNOLD BECHTOLDT

Building large-scale Internal Developer Platforms: Core Principles

Arnold’s talk navigates the complexities of cloud computing, transcending its enigmatic allure. He highlights RTL Data’s internal developer platform, serving 30+ teams with diverse technologies. Arnold underscores RTL’s decentralized infrastructure, which has rapidly produced over 400 GCP projects and 100 GKE clusters in 2-3 years, showcasing its commitment to scalable and efficient software delivery.

ANAÏS URLICHS

Looking into the Closet from Code to Cloud with Bills of Material

Anaïs talks about Bills of Material (BOM) and how they are changing. In her presentation, she shows how to deal with differences in tool and BOM outputs. Using easy-to-understand demos, she explains how to make BOMs with Trivy, Syft, and Microsoft SBOM. Anais focuses on checking security and quality with Lockheed Martin’s sbom-comparator. She also shows how to use BOMs in security scans and reduce vulnerability scan noise with VEX documents.

VISHWA KRISHNAKUMAR

Scaling Up, Not Out: Managing Enterprise Demands in a Growing SaaS Startup

Every founder reaches a crucial point when their product gains traction. They attract big clients, like software leaders, banks, and retail giants, who pay generously for niche solutions. While exciting, catering to these clients‘ demands can veer the product away from its original vision. Vishwa’s talk advises founders on balancing enterprise customer needs while staying true to their company’s vision.

Save your Ticket!

Curious about the event program and excited to join stackconf 2024 on June 18 & 19 in Berlin? Act now and reserve your spot! Make sure you don’t miss any important stackconf updates and sign up for our mailing list. Stay connected for upcoming announcements!

Setze Deine Reise fort mit unseren Monitoring und Automation Trainings

In der sich ständig wandelnden Welt der IT-Landschaft sind Monitoring- und Automation-Technologien heute unerlässlich. Umso wichtiger ist es, sein Wissen und seine Fähigkeiten regelmäßig zu updaten. Hier präsentieren wir Dir eine Auswahl unserer Trainings, die Dich von den Grundlagen bis zur Expertise in den Bereichen Monitoring und IT-Automation führen.

Monitoring Schulungen

Prometheus Fundamentals

Prometheus hat sich als leistungsfähiges Werkzeug in der Open-Source und Monitoring-Welt fest etabliert. Im Prometheus Fundamentals Training zeigen wir Dir, wie Prometheus multidimensional Daten sammelt, analysiert und es Dir dadurch eine präzise Überwachung von Ressourcenauslastung und Anwendungsleistung ermöglicht.

Durch Skalierbarkeit, Effizienz und eine engagierte Community bietet Prometheus eine zuverlässige Lösung für das proaktive Management moderner IT-Infrastrukturen.

Finde Dein Training zum nächstmöglichen Termin.

Icinga 2 Advanced

Die Icinga 2 Advanced Schulung baut auf die Themen des Fundamentals-Trainings auf und versetzt Dich in die Lage, auch komplexe Infrastrukturen mit Icinga 2 zu überwachen. Der Fokus hierbei liegt vor allem auf der verteilten und hochverfügbaren Architektur von Icinga 2, sowie der Automatisierung der Konfiguration mit den Importmöglichkeiten des Directors.

Finde Dein Training zum nächstmöglichen Termin.

IT Automation Schulungen

Ansible Fundamentals

Ansible ist ein leistungsstarkes Werkzeug für die Automatisierung von IT-Prozessen, Konfigurationsautomatisierung, Playbook-Erstellung und Nutzung von Inventar-Dateien. Mit Ansible kannst Du wiederkehrende Aufgaben automatisieren, was zu einer erheblichen Zeitersparnis führt und somit Ressourcen schont.

Unser Ansible Fundamentals Training vermittelt Dir Grundlagen der Konfigurationsautomatisierung und bietet eine solide Basis für die effiziente Nutzung von Ansible in verschiedenen Szenarien.

Finde Dein Training zum nächstmöglichen Termin.

Ansible AWX

Ansible AWX ist eine Open-Source-Plattform, basierend auf dem leistungsstarken Automatisierungstool Ansible. Mit einer intuitiven, webbasierten Benutzeroberfläche bietet AWX eine zentrale Steuerung über Ansible-Projekte, Playbooks und Jobs.

Die Plattform zeichnet sämtliche Aktivitäten auf, was Dir eine detaillierte Überwachung ermöglicht und Dir Fehleranalysen und Sicherheitsprüfungen vereinfacht. Im Ansible AWX Training lernst Du Funktionen wie die Integration von Versionskontrollsystemen, z.B. Git.

Dank der rollenbasierten Zugriffskontrolle hast Du als Administrator die volle Kontrolle über Berechtigungen auf verschiedenen Ebenen. Wir zeigen Dir in unserem Training, wie Du durch parallele Jobausführungen, über verschiedene Hosts hinweg die Zusammenarbeit in deinem Unternehmen fördern kannst.

Lerne, wie Dir Ansible AWX eine effektive, kontrollierte und skalierbare Automatisierung ermöglicht, die sich nahtlos in bestehende Infrastrukturen integrieren lässt.

Finde Dein Training zum nächstmöglichen Termin.

Ansible Advanced

Mit Ansible kannst Du sowohl einfache als auch anspruchsvolle Bereitstellungsskripte intuitiv erstellen und Deine Automatisierung vielseitig und effizient gestalten. In unserer Ansible Advanced Schulung erweitern wir Deine Ansible-Kenntnisse und machen Dich zum Überflieger.

Erfahre alles über Fact Caching, nutze diese Facts effektiv, programmiere ein dynamisches Inventory und schreibe Python Lookup Plugins. Entdecke das innovative Konzept der Collections. Kurzum – wir machen dich Schritt für Schritt zum Ansible-Experten!

Finde Dein Training zum nächstmöglichen Termin.

Setze Deine Reise zum IT-Experten fort

Diese Trainings helfen Dir, Deine Kenntnisse im Bereich Monitoring und IT-Automation zu vertiefen. Egal ob Prometheus, Icinga 2 oder Ansible, erweitere Deine Fähigkeiten und werde zum Experten! Profitiere vom Know-how unserer Spezialisten und buche Dein Training über unseren Schulungskalender oder nimm Kontakt auf.

ALEX PSHE

ALEX PSHE