Konfigurationsmanagement in Rechenzentren ist aus der modernen „DevOps“ IT nicht mehr wegzudenken. Puppet, Chef, Salt oder Ansible automatisieren Umgebungen von mittelständischen Unternehmen bis hin zu Weltkonzernen.

Konfigurationsmanagement in Rechenzentren ist aus der modernen „DevOps“ IT nicht mehr wegzudenken. Puppet, Chef, Salt oder Ansible automatisieren Umgebungen von mittelständischen Unternehmen bis hin zu Weltkonzernen.

Wenn wir die verschiedenen Lösungen betrachten, bedienen sie sich alle einer eigenen Sprache, diese soll möglichst einfach unsere Infrastruktur abbilden. („infrastructure as a code“)

Da nicht jeder Admin im Tagesgeschäft programmiert, kann so eine Sprache ein Hindernis werden und Arbeitsschritte vielleicht verkomplizieren.

Seit einiger Zeit beschäftige ich mit Ansible, ein Tool welches ohne vorinstallierte Clients arbeitet und eine Konfiurationsprache basierend auf YAML nutzt.

Um Ansible zu nutzen muss lediglich eine SSH Verbindung, ein Benutzer mit Rootrechten und ein Inventarfile bestehen.

Das Sprache im YAML Format ist für jeden leicht lesbar und sofort verständlich.

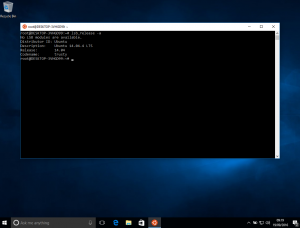

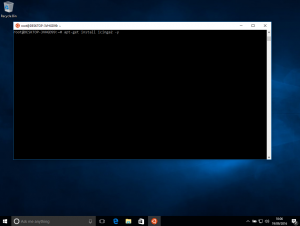

Ansible kann entweder lokal auf dem Arbeitsrechner oder auf einem sogenannten „Managementnode“ über bereitgestellte Pakete installiert werden.

Unter „/etc/ansible/“ legen wir nach der Installation zusätzlich ein Inventar an.

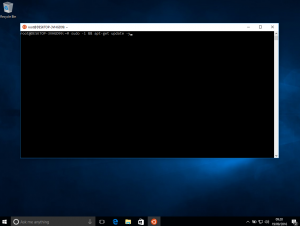

$ cat /etc/ansible/hosts

host01.localdomain ansible_ssh_host=10.10.10.11

host02.localdomain ansible_ssh_host=10.10.10.12</pre lang="bash">

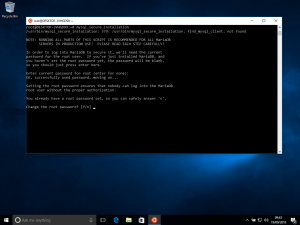

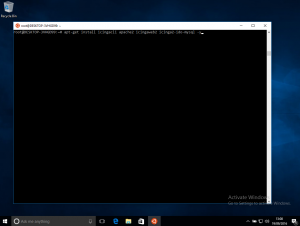

Wenn Ansible installiert und ein Inventarfile erstellt wurde, kann die Verbindung zum Server mit dem Modul „ping“ getestet werden. Hierbei versucht Ansible den Server per SSH zu erreichen und einzuloggen.

$ ansible host01.localdomain -m ping

host01.localdomain | success >> {

"changed": false,

"ping": "pong"

}</pre lang="bash">

Alternativ kann statt dem Hostalias auch „all“ gesetzt werden um alle Hosts aus dem Inventar zu prüfen.

$ ansible all -m ping</pre lang="bash">

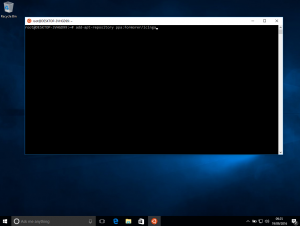

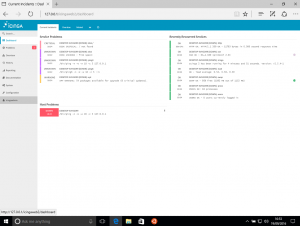

Ansible bietet zahlreiche Module mit denen Pakete installiert, Dateien kopiert oder bearbeitet werden können. Hier findet ihr eine Übersicht aller Module

Tasks verwenden diese Module um die Arbeitsschritte in Playbooks oder Rollen auszuführen.

Beispiel eines Playbooks:

$ cat ansible_starter.yml

---

- hosts: all <- Führe die Tasks auf allen Hosts aus

tasks:

- name: say hello to everyone <- Name des Tasks

debug: <- Name des Moduls

msg: "Hello World" <- Parameter des Moduls

– name: install ntp

yum:

name: ntp

state: installed

</pre lang=“yaml“>

$ ansible-playbook -s ansible_starter.yml

</pre lang="bash">

Diese Task werden der Reihenfolge nach auf dem Zielhost ausgeführt und damit haben wir schon eine kleine Automation geschaffen. Probiert's aus!

Da Ansible im Sturm mein Automationsherz erobern konnte war ich mit meinem Kollegen dieses Jahr auf dem Ansible Fest in London, einen Erfahrungsbericht der Veranstaltung findet ihr hier.